Les derniers modèles d’IA de la série o d’OpenAI sont conçus pour améliorer la sécurité des systèmes d’IA grâce à une compréhension plus approfondie des règles et à des capacités de raisonnement. Contrairement au passé qui s’appuyait uniquement sur des exemples d’apprentissage, ce modèle peut comprendre et appliquer de manière proactive les directives de sécurité pour bloquer efficacement les requêtes nuisibles. L'article détaille le processus de formation en trois étapes du modèle o1 et ses performances au-delà des autres systèmes d'IA traditionnels lors des tests de sécurité. Cependant, même avec le modèle o1 amélioré, il existe toujours des possibilités de manipulation, ce qui met en évidence les défis actuels dans le domaine de la sécurité de l'IA.

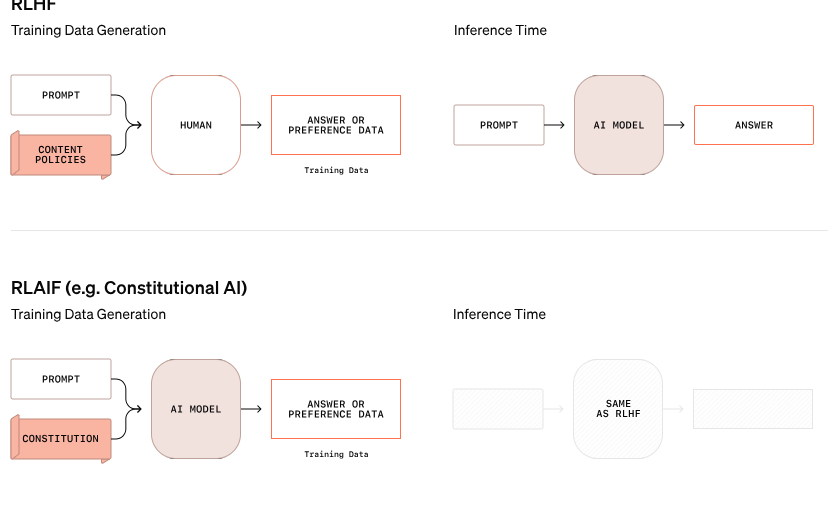

OpenAI a annoncé une nouvelle approche de la sécurité de l'IA qui vise à améliorer la sécurité des systèmes d'IA en modifiant la façon dont ils gèrent les règles de sécurité. Ce nouveau modèle de la série O ne repose plus uniquement sur l'apprentissage des bons et des mauvais comportements à partir d'exemples, mais est capable de comprendre et de raisonner activement sur des consignes de sécurité spécifiques.

Dans un exemple tiré des recherches d'OpenAI, lorsqu'un utilisateur tentait d'obtenir des instructions pour une activité illégale via un texte crypté, le modèle réussissait à décoder les informations mais rejetait la demande, citant spécifiquement la règle de sécurité qui serait violée. Ce processus de raisonnement étape par étape montre dans quelle mesure le modèle suit efficacement les directives de sécurité pertinentes.

Le processus de formation de ce modèle o1 est divisé en trois étapes. Tout d’abord, le modèle apprend comment aider. Ensuite, grâce à un apprentissage supervisé, le modèle étudie des consignes de sécurité spécifiques. Enfin, le modèle utilise l'apprentissage par renforcement pour s'entraîner à appliquer ces règles, une étape qui aide le modèle à véritablement comprendre et internaliser ces consignes de sécurité.

Lors des tests d'OpenAI, le modèle o1 nouvellement lancé a obtenu des performances nettement supérieures à celles des autres systèmes grand public en termes de sécurité, tels que GPT-4o, Claude3.5Sonnet et Gemini1.5Pro. Le test, qui comprenait dans quelle mesure le modèle rejetait les requêtes nuisibles et permettait aux requêtes appropriées, a montré que le modèle o1 obtenait les meilleurs scores en termes de précision et de résistance aux tentatives de jailbreak.

Le co-fondateur d'OpenAI, Wojciech Zaremba, a déclaré sur les plateformes sociales qu'il était très fier de ce travail d'"alignement réfléchi" et estime que ce type de modèle de raisonnement peut être aligné d'une manière complètement nouvelle, en particulier lors du développement de l'intelligence artificielle générale (AGI), faire en sorte que le système soit cohérent avec les valeurs humaines est un défi majeur.

Malgré les affirmations de progrès d'OpenAI, un pirate informatique nommé "Pline le Libérateur" a montré que même les nouveaux modèles o1 et o1-Pro peuvent être manipulés pour enfreindre les directives de sécurité. Pline a réussi à faire en sorte que le modèle génère du contenu pour adultes et même partage des instructions pour préparer des cocktails Molotov, bien que le système ait initialement rejeté ces demandes. Ces incidents mettent en évidence la difficulté de contrôler ces systèmes d’IA complexes car ils fonctionnent sur la base de probabilités plutôt que de règles strictes.

Zaremba a déclaré qu'OpenAI compte environ 100 employés dédiés à la sécurité de l'IA et à la cohérence avec les valeurs humaines. Il a soulevé des questions sur les approches de ses concurrents en matière de sécurité, en particulier xAI d'Elon Musk, qui donne la priorité à la croissance du marché plutôt qu'aux mesures de sécurité, et Anthropic, qui a récemment lancé un agent d'IA sans garanties appropriées. Zaremba estime que cela entraînera « d'énormes retours négatifs » sur OpenAI.

Blog officiel : https://openai.com/index/deliberative-alignment/

Souligner:

Les nouveaux modèles de la série o d'OpenAI peuvent raisonner de manière proactive sur les règles de sécurité et améliorer la sécurité du système.

Le modèle o1 surpasse les autres systèmes d’IA traditionnels en rejetant les requêtes nuisibles et en termes de précision.

Malgré les améliorations, les nouveaux modèles peuvent encore être manipulés et les défis de sécurité restent importants.

Dans l'ensemble, les modèles de la série o d'OpenAI ont fait des progrès significatifs dans le domaine de la sécurité de l'IA, mais ils ont également exposé la complexité et les défis actuels de la sécurité des grands modèles de langage. Il faudra continuer à investir des efforts supplémentaires à l’avenir pour faire face véritablement et efficacement aux risques de sécurité liés à l’IA.