Pré-formation de télé-connaissances pour l'analyse des défauts

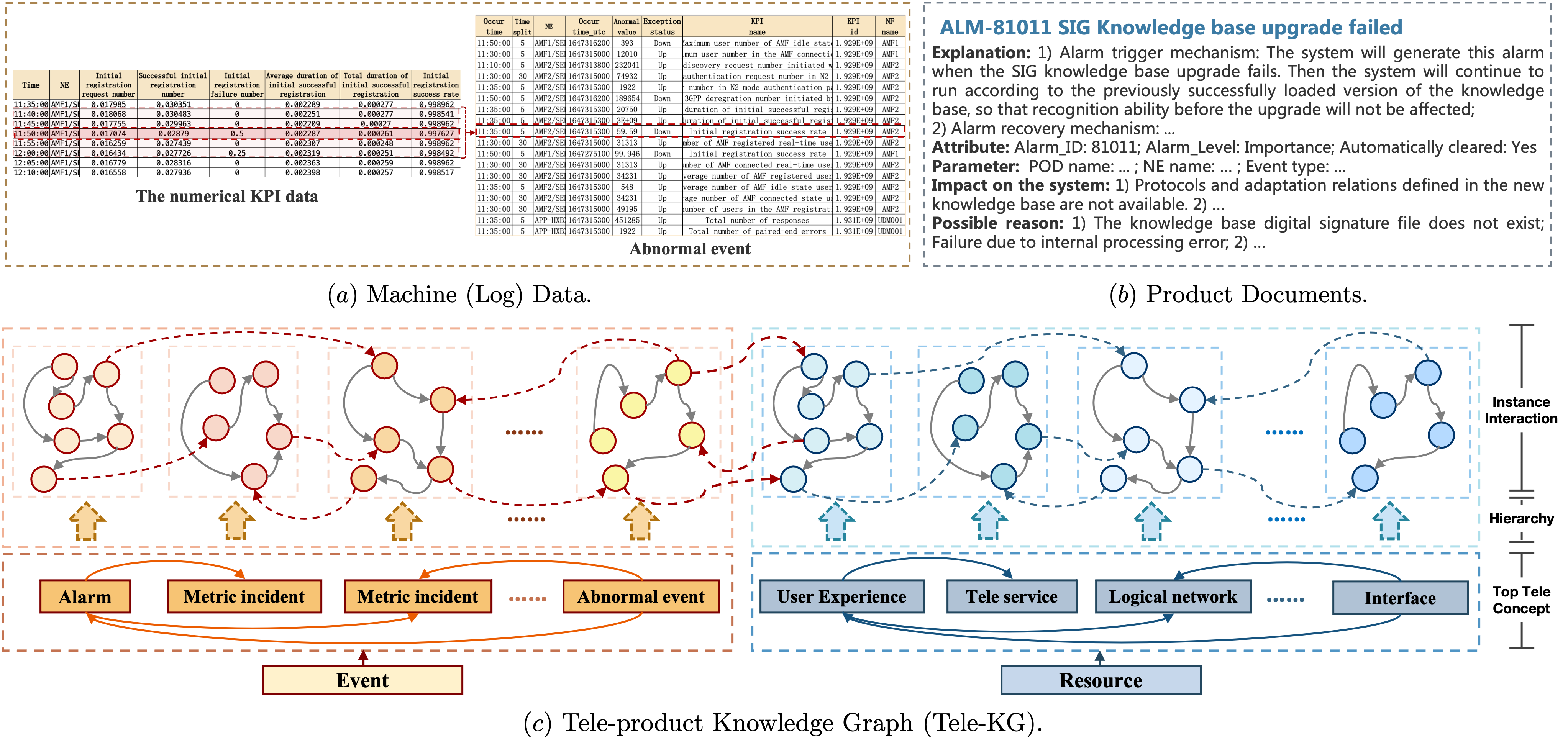

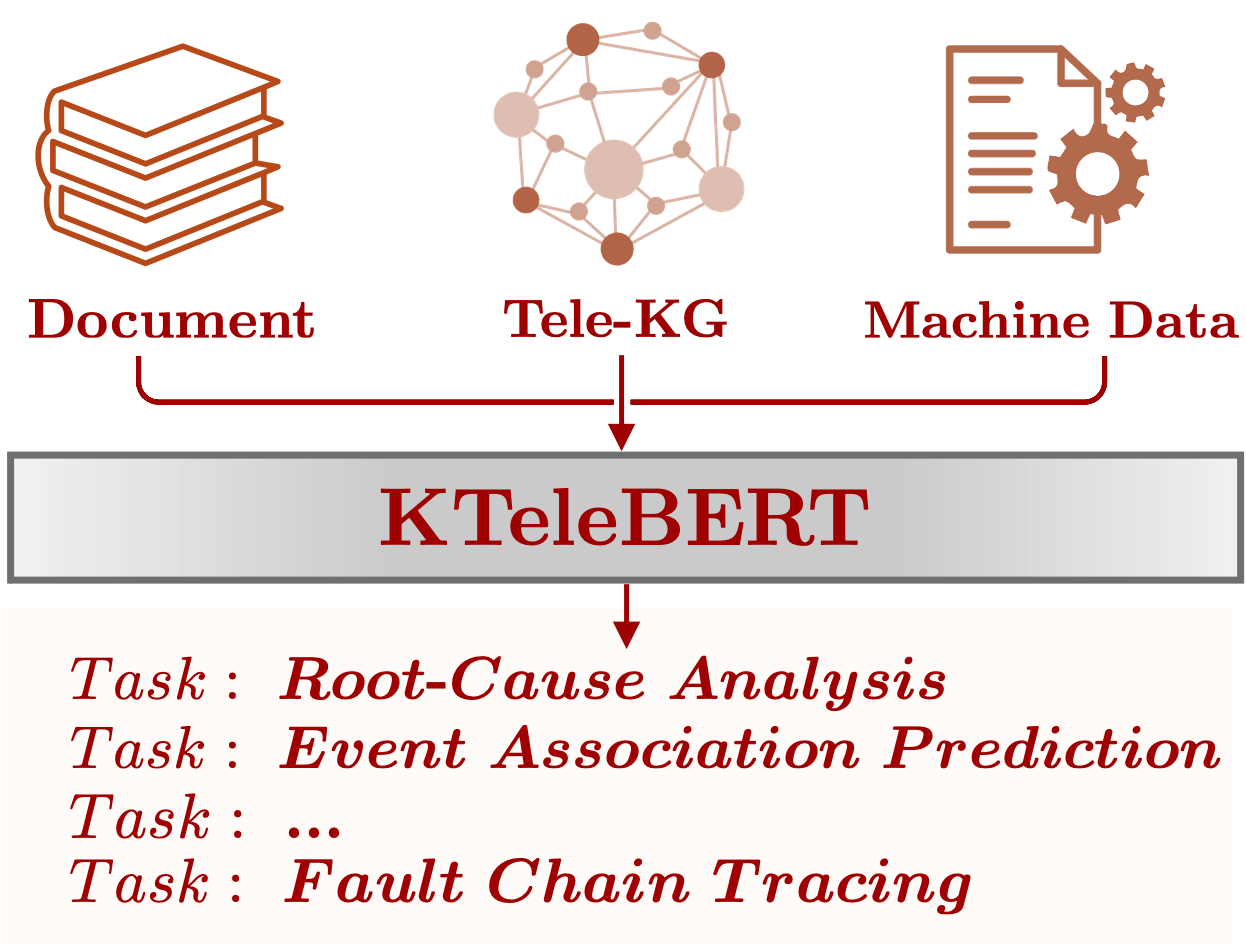

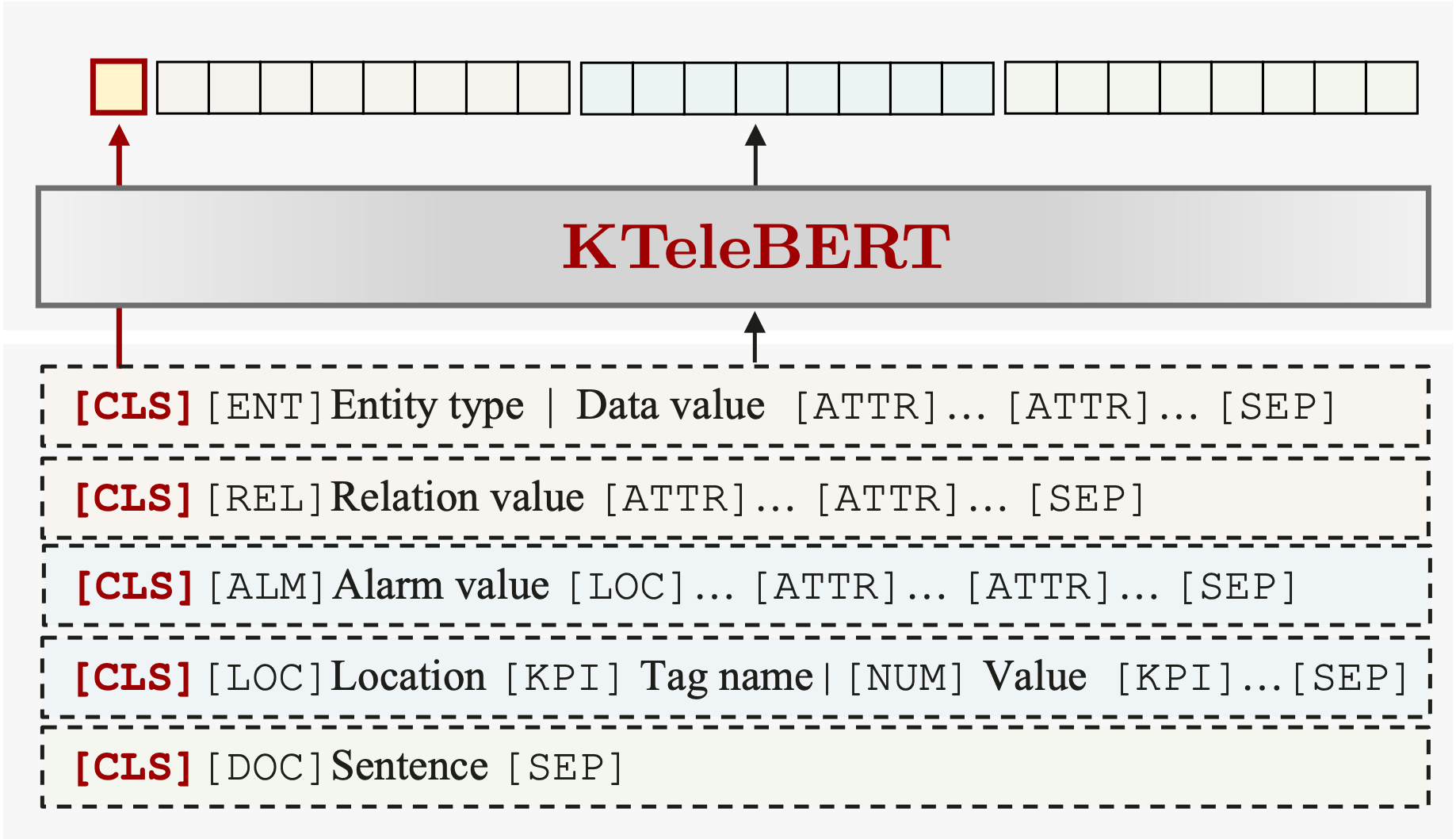

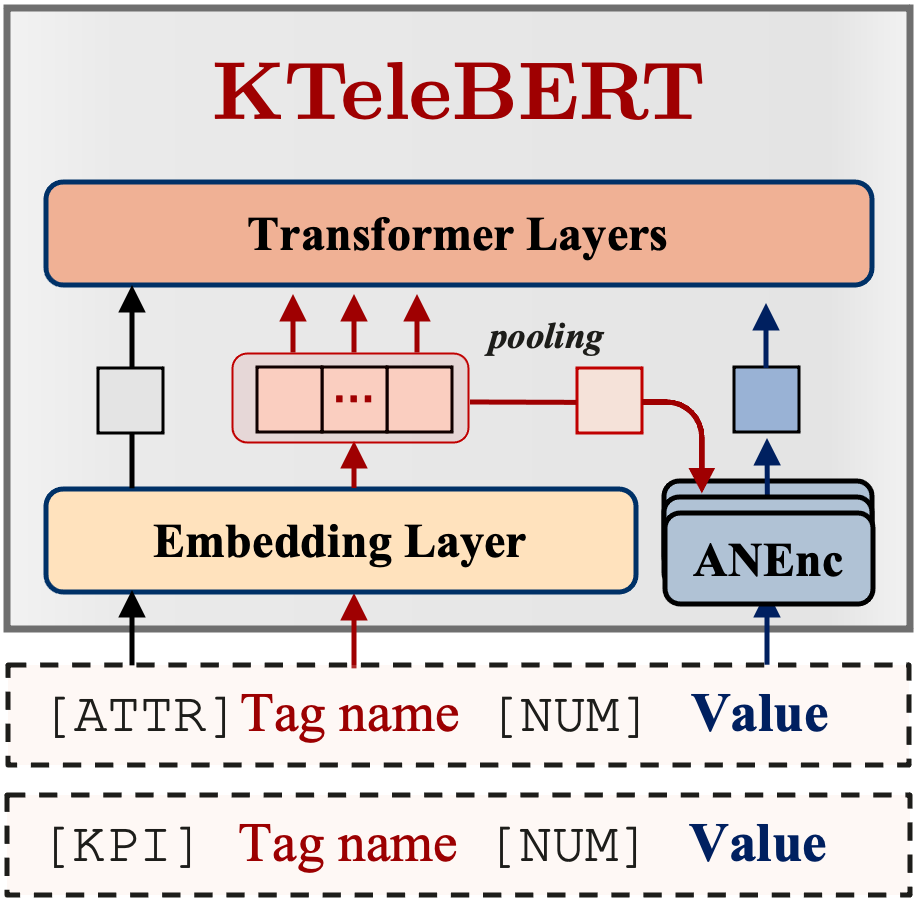

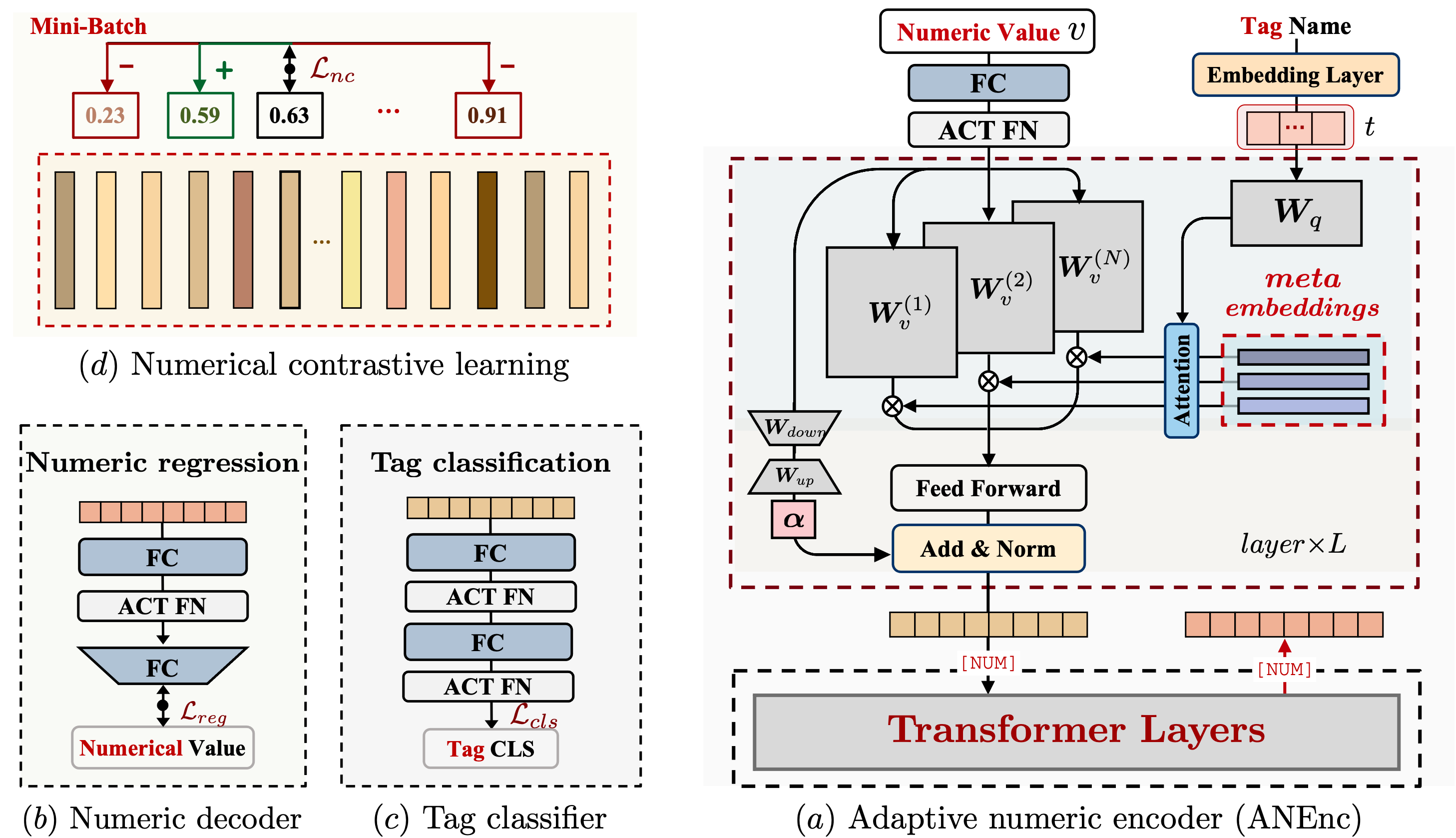

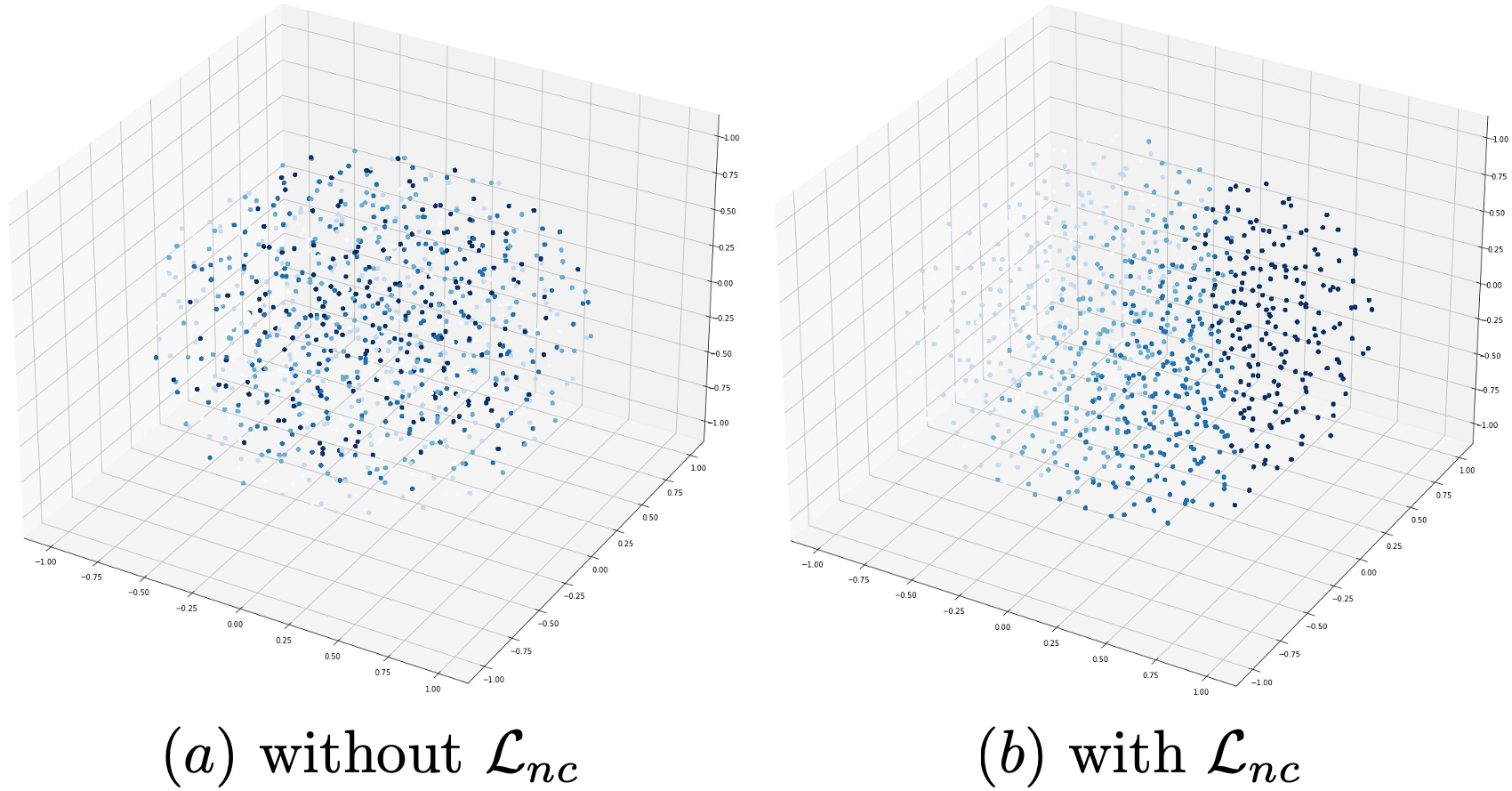

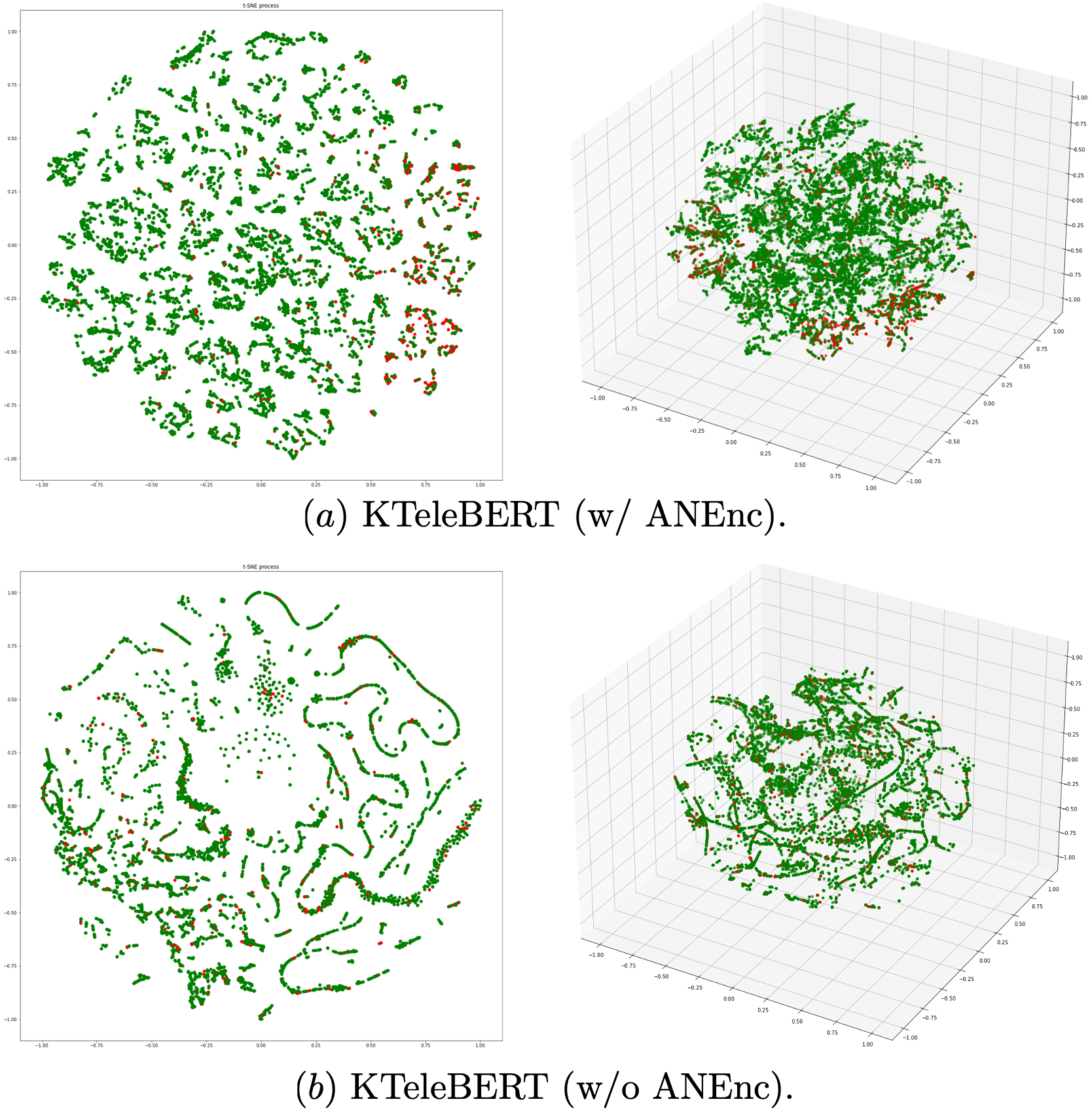

Auteur: Zhuo Chen †, Wen Zhang †, Yufeng Huang, Mingyang Chen, Yuxia Geng, Hongtao Yu, Zhen BI, Yichi Zhang, Zhen Yao, Huajun Chen (College of Computer Science, Zhejiang University ) Wenting Song, Xinliang Wu, Yi Yang, Mingyi Chen, Zhaoyange Yingying Li, Lei Cheng (NAIE PDU, Huawei Technologies Co., Ltd.) Dans cet article, nous proposons un modèle de langue pré-domaine de télécommunications nommé Telebert pour apprendre les connaissances sémantiques générales dans le domaine des télécommunications avec sa version améliorée KTELEBERT , qui incorpore les connaissances de la connexion de la machine et les connaissances sur le krotage.

here . Compte tenu de la sensibilité de certaines données, nous ne pouvons pas les publier tous.

transformers >= 4.21.2PyTorch >= 1.6.0tqdmltp Pour plus de détails: config.py

--train_strategy

--batch_size

--batch_size_ke

--batch_size_od

--batch_size_ad

--epoch

--save_model {0,1}

--save_pretrain {0,1}

--from_pretrain {0,1}

--dump_path Experiment dump path

--random_seed

--train_ratio ratio for train/test

--final_mlm_probability

--mlm_probability_increase {linear,curve}

--mask_stratege {rand,wwm,domain}

--ernie_stratege

--use_mlm_task {0,1}

--add_special_word {0,1}

--freeze_layer {0,1,2,3,4}

--special_token_mask {0,1}

--emb_init {0,1}

--cls_head_init {0,1}

--use_awl {0,1}

--mask_loss_scale

--ke_norm

--ke_dim

--ke_margin

--neg_num

--adv_temp The temperature of sampling in self-adversarial negative sampling.

--ke_lr

--only_ke_loss

--use_NumEmb

--contrastive_loss {0,1}

--l_layers L_LAYERS

--use_kpi_loss

--only_test {0,1}

--mask_test {0,1}

--embed_gen {0,1}

--ke_test {0,1}

--ke_test_num

--path_gen

--order_load

--order_num

--od_type {linear_cat,vertical_attention}

--eps EPS label smoothing

--num_od_layer

--plm_emb_type {cls,last_avg}

--order_test_name

--order_threshold

--rank RANK rank to dist

--dist DIST whether to dist

--device DEVICE device id (i.e. 0 or 0,1 or cpu)

--world-size WORLD_SIZE number of distributed processes

--dist-url DIST_URL url used to set up distributed training

--local_rank LOCAL_RANK

bash run.sh bash test.sh Note :

.sh pour la modification des paramètres par défaut. Veuillez condiquer ce document si vous utilisez le code de notre travail. Merci beaucoup :)

@inproceedings{DBLP:conf/icde/00070HCGYBZYSWY23,

author = {Zhuo Chen and

Wen Zhang and

Yufeng Huang and

Mingyang Chen and

Yuxia Geng and

Hongtao Yu and

Zhen Bi and

Yichi Zhang and

Zhen Yao and

Wenting Song and

Xinliang Wu and

Yi Yang and

Mingyi Chen and

Zhaoyang Lian and

Yingying Li and

Lei Cheng and

Huajun Chen},

title = {Tele-Knowledge Pre-training for Fault Analysis},

booktitle = {{ICDE}},

pages = {3453--3466},

publisher = {{IEEE}},

year = {2023}

}