transformer tensorflow

1.0.0

La mise en œuvre de TensorFlow de l'attention est tout ce dont vous avez besoin. (2017. 6)

Projet init par HB-bases

.

├── config # Config files (.yml, .json) using with hb-config

├── data # dataset path

├── notebooks # Prototyping with numpy or tf.interactivesession

├── transformer # transformer architecture graphs (from input to logits)

├── __init__.py # Graph logic

├── attention.py # Attention (multi-head, scaled_dot_product and etc..)

├── encoder.py # Encoder logic

├── decoder.py # Decoder logic

└── layer.py # Layers (FFN)

├── data_loader.py # raw_date -> precossed_data -> generate_batch (using Dataset)

├── hook.py # training or test hook feature (eg. print_variables)

├── main.py # define experiment_fn

└── model.py # define EstimatorSpec

Référence: HB-Config, ensemble de données, expériences_fn, Estimatorspec

Peut contrôler tout l'environnement expérimental .

Exemple: check-tiny.yml

data :

base_path : ' data/ '

raw_data_path : ' tiny_kor_eng '

processed_path : ' tiny_processed_data '

word_threshold : 1

PAD_ID : 0

UNK_ID : 1

START_ID : 2

EOS_ID : 3

model :

batch_size : 4

num_layers : 2

model_dim : 32

num_heads : 4

linear_key_dim : 20

linear_value_dim : 24

ffn_dim : 30

dropout : 0.2

train :

learning_rate : 0.0001

optimizer : ' Adam ' ('Adagrad', 'Adam', 'Ftrl', 'Momentum', 'RMSProp', 'SGD')

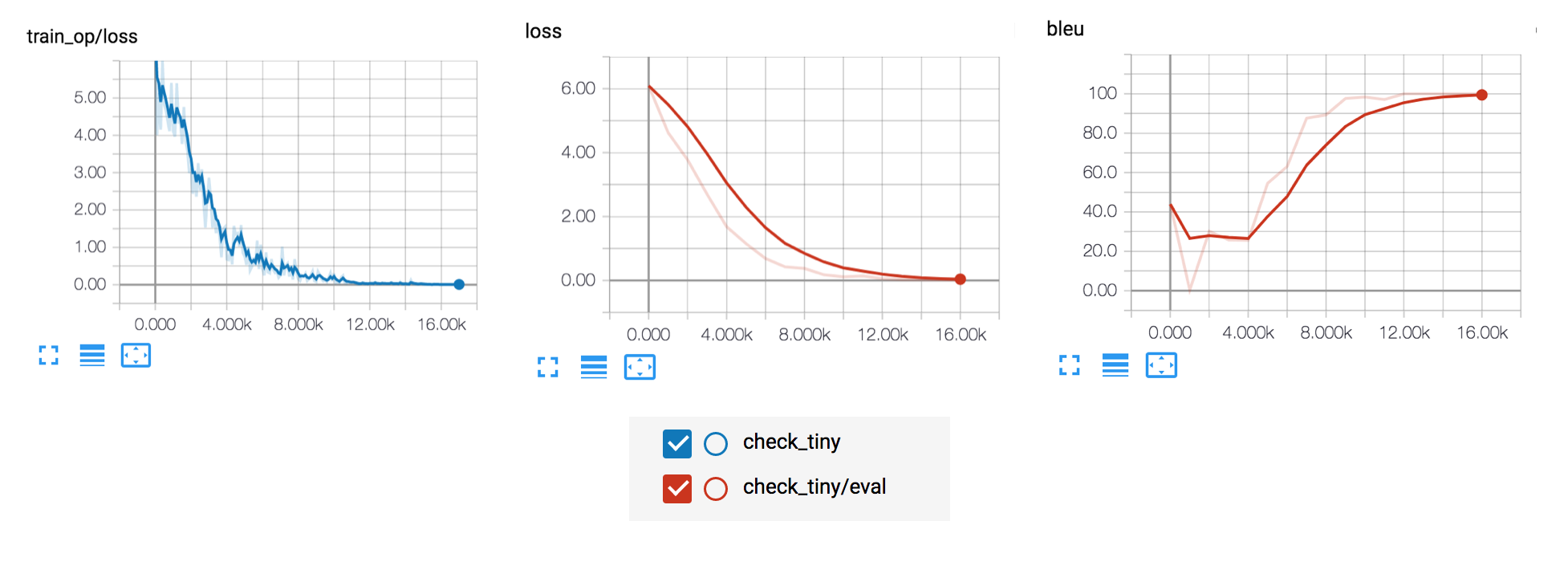

train_steps : 15000

model_dir : ' logs/check_tiny '

save_checkpoints_steps : 1000

check_hook_n_iter : 100

min_eval_frequency : 100

print_verbose : True

debug : False

slack :

webhook_url : " " # after training notify you using slack-webhookcheck-tiny est un ensemble de données avec environ 30 phrases qui sont traduites du coréen en anglais. (Recommander le lire :)) Installer les exigences.

pip install -r requirements.txt

Ensuite, les données brutes pré-processus.

python data_loader.py --config check-tiny

Enfin, commencez le train et évaluez le modèle

python main.py --config check-tiny --mode train_and_evaluate

Ou, vous pouvez utiliser un ensemble de données anglais-vietnamien IWSLT'15.

sh prepare-iwslt15.en-vi.sh # download dataset

python data_loader.py --config iwslt15-en-vi # preprocessing

python main.py --config iwslt15-en-vi --mode train_and_evalueate # start training

Après l'entraînement, vous pouvez tester le modèle.

python predict.py --config {config} --src {src_sentence}$ python predict.py --config check-tiny --src " 안녕하세요. 반갑습니다. "

------------------------------------

Source: 안녕하세요. 반갑습니다.

> Result: Hello . I ' m glad to see you . <s> vectors . <s> Hello locations . <s> will . <s> . <s> you . <s> ✅: Travailler

◽: Non encore testé.

evaluate : évaluer les données d'évaluation.extend_train_hooks : étend les crochets pour la formation.reset_export_strategies : réinitialise les stratégies d'exportation avec les stratégies new_export_stares.run_std_server : démarre un serveur TensorFlow et rejoint le thread de service.test : teste la formation, l'évaluation et l'exportation de l'estimateur pour une seule étape.train : Ajustez l'estimateur à l'aide des données d'entraînement.train_and_evaluate : Formation et évaluation entrelacées. tensorboard --logdir logs

Dongjun Lee ([email protected])