M3Exam

1.0.0

Ceci est le référentiel pour M3Exam: une référence multilingue, multimodale et multi-niveaux pour examiner les modèles de grands langues.

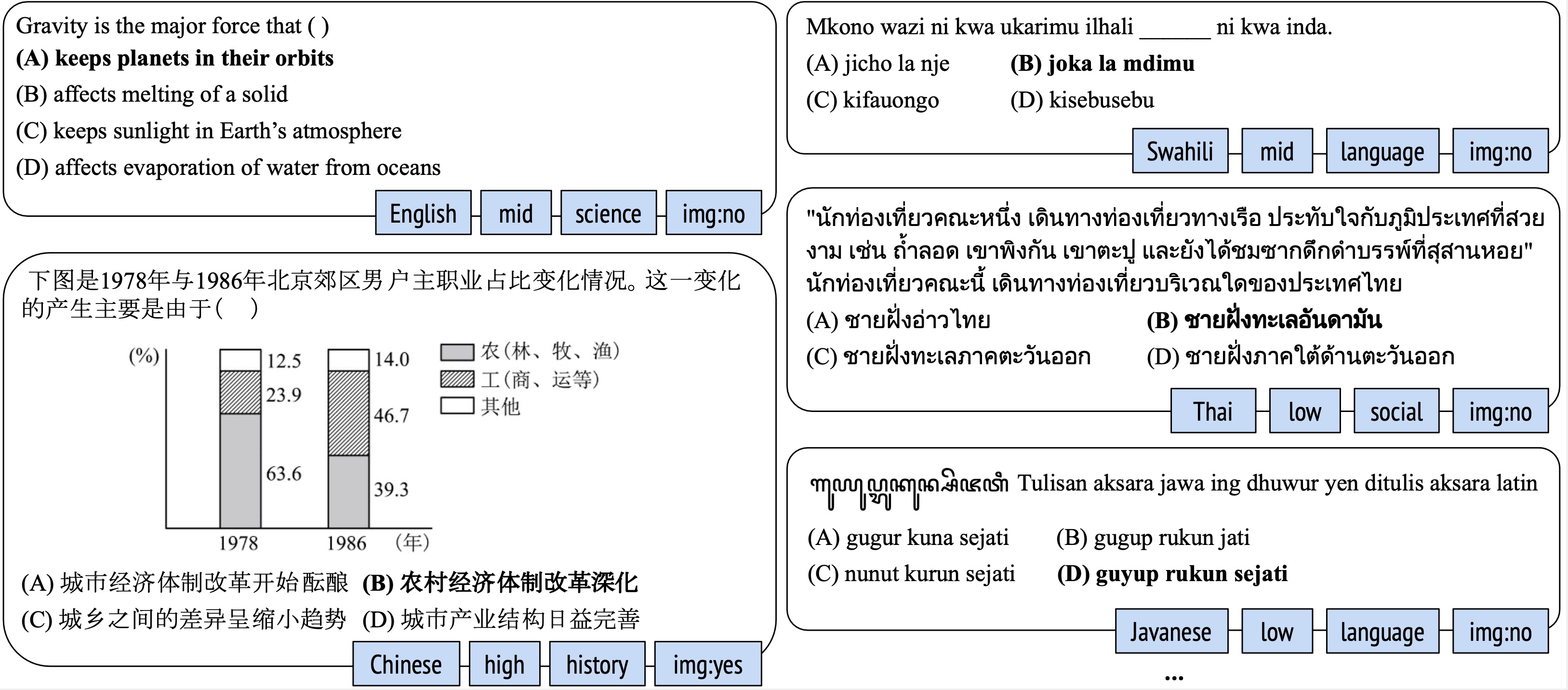

TL; DR: Nous introduisons M3Exam, une nouvelle référence provenant de questions d'examen humain réelles et officielles pour l'évaluation des LLM dans un contexte multilingue, multimodal et à plusieurs niveaux.

data/

multimodal-questions/ <- questions requiring images

xx-questions-image.json <- file containing the questions, xx is a language

iamges-xx/ <- folder containg all the images for xx

text-questions/ <- questions with pure text

xx-questions-dev.json <- held-out data (e.g., can be used as in-context examples)

xx-questions-test.json <- main test data for evaluation

with open ( f'./data/text-question/ { lang } -questions-dev.json' , 'w' ) as f :

data = json . load ( f ) # data is a list of questions {

'question_text': 'Which Civil War event occurred first?',

'background_description': [],

'answer_text': '2',

'options': ['(1) battle of Gettysburg',

'(2) firing on Fort Sumter',

'(3) assassination of President Lincoln',

'(4) Emancipation Proclamation'],

'need_image': 'no',

'language': 'english',

'level': 'mid',

'subject': 'social',

'subject_category': 'social-science',

'year': '2006'

}

python main.py

--setting zero-shot

--model chat

--use_api

--selected_langs "['english']"

--api_key #put your key here

quick_run.sh , qui fonctionnera sur 10 questions en anglais et produira english-pred.json dans le dossier de sortie correspondanteval.sh pour vérifier les performances de ces 10 exemples!run.sh pour des paramètres plus détaillés python main.py

--setting zero-shot

--model chat

--use_api

--selected_langs "['english']"

--selected_levels "['low', 'mid', 'high']"

--num_samples all

--api_key #put your key here

* specify the languages you want to run through `--selected_langs`

* running on all questions, set `--num_samples all`

Si vous trouvez cela utile dans vos recherches, envisagez de le citer:

@article{zhang2023m3exam,

title={M3Exam: A Multilingual, Multimodal, Multilevel Benchmark for Examining Large Language Models},

author={Wenxuan Zhang and Sharifah Mahani Aljunied and Chang Gao and Yew Ken Chia and Lidong Bing},

year={2023},

eprint={2306.05179},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Mot de passe: 12317