Le référentiel principal pour les questions multilingues de pointe répondant à la recherche et au développement.

PrimeQA est un référentiel open source public qui permet aux chercheurs et aux développeurs de former des modèles de pointe pour la réponse aux questions (QA). En utilisant Primeqa, un chercheur peut reproduire les expériences décrites dans un article publié dans la dernière conférence NLP tout en profitant de la capacité de télécharger des modèles pré-formés (à partir d'un référentiel en ligne) et de les exécuter sur leurs propres données personnalisées. Primeqa est construit sur la boîte à outils Transformers et utilise des ensembles de données et des modèles directement téléchargeables.

Les modèles au sein de PrimeQA prennent en charge la réponse aux questions de bout en bout. Primeqa répond aux questions via

Certains exemples de modèles (applicables sur les ensembles de données de référence) sont pris en charge:

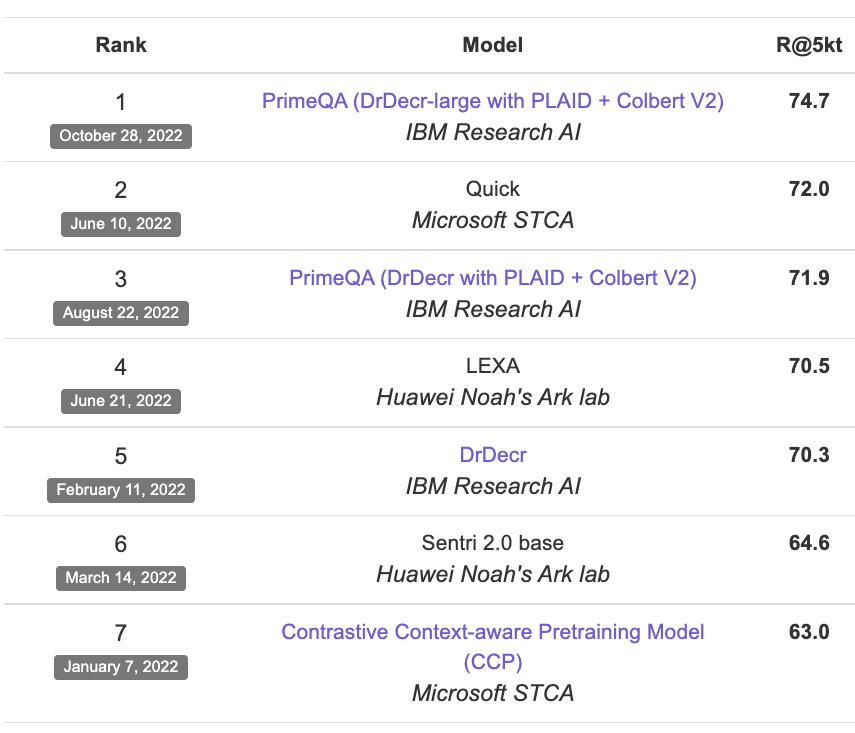

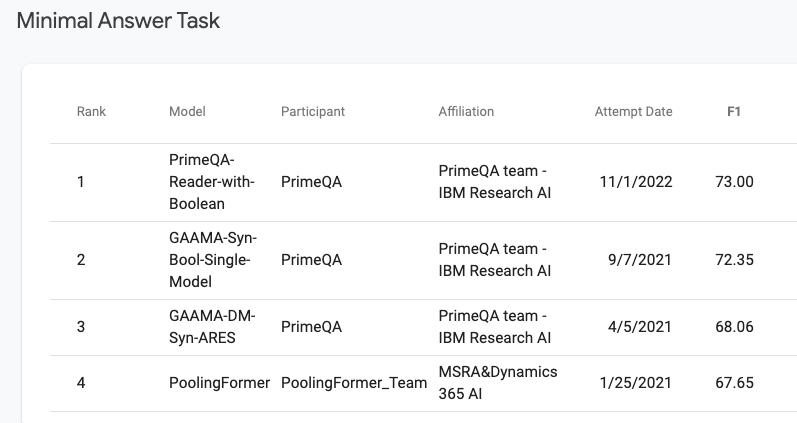

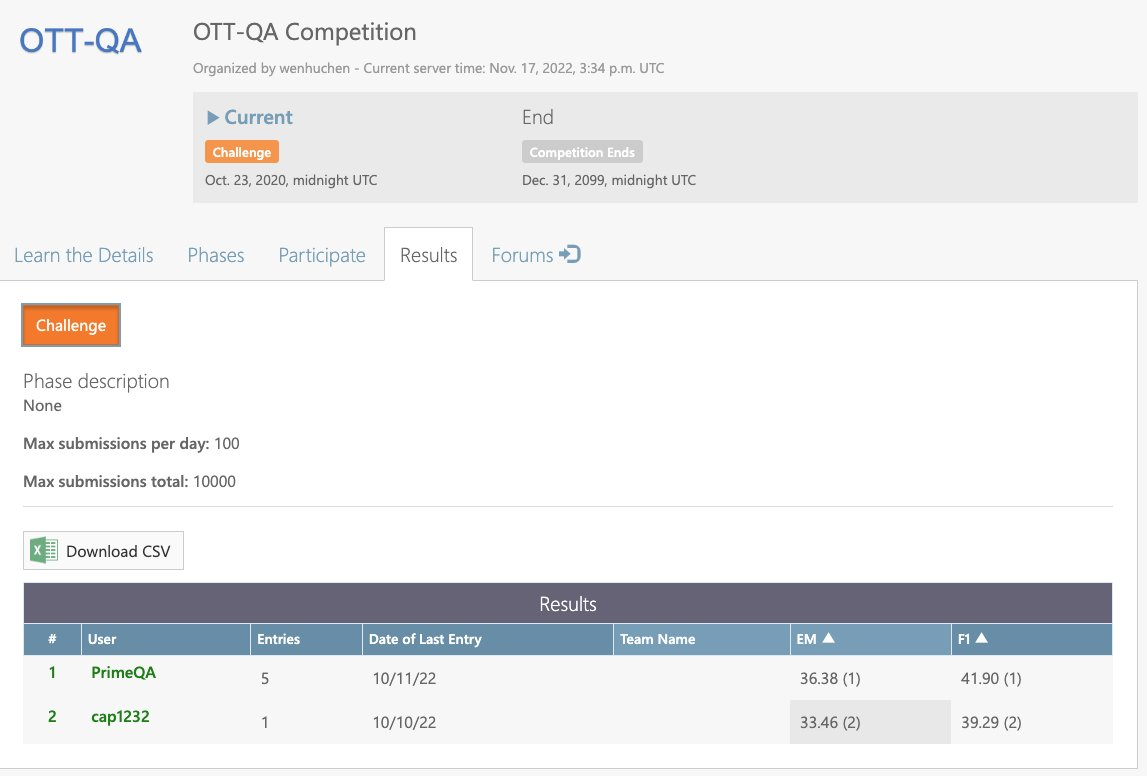

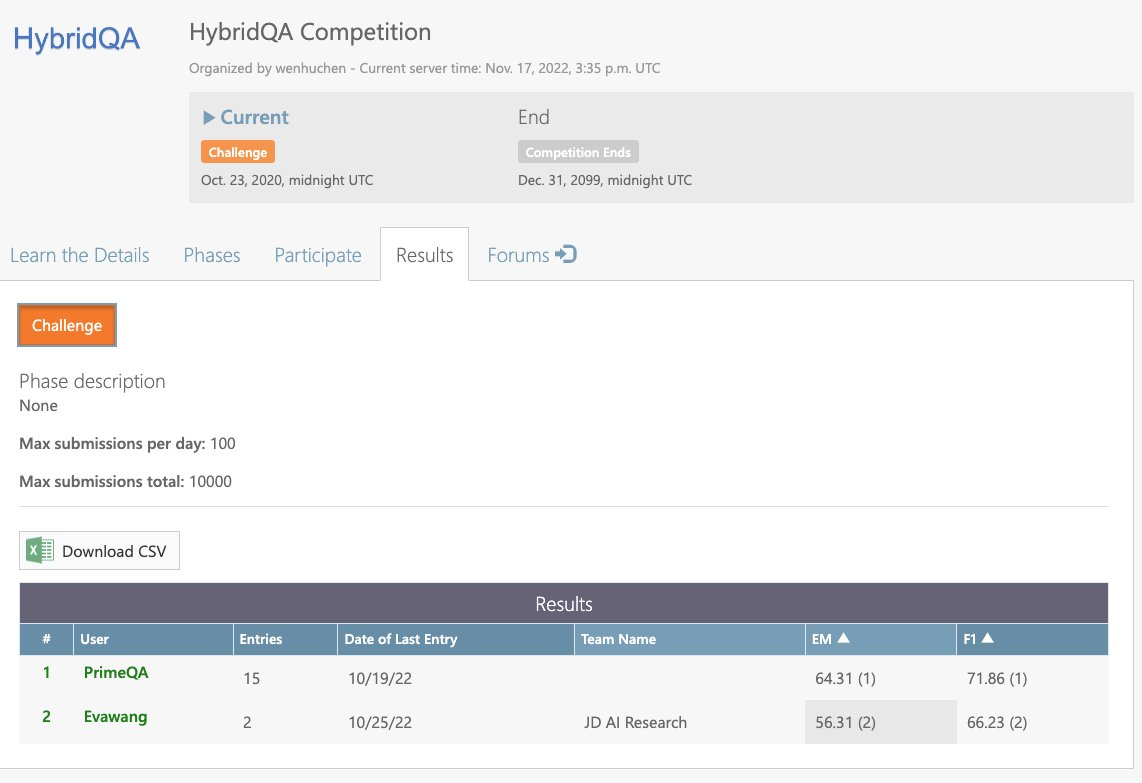

Primeqa est au sommet de plusieurs classements: XOR-Tydi, Tydiqa-Main, Ott-QA et Hybridqa.

Doc d'installation

# cd to project root

# If you want to run on GPU make sure to install torch appropriately

# E.g. for torch 1.11 + CUDA 11.3:

pip install ' torch~=1.11.0 ' --extra-index-url https://download.pytorch.org/whl/cu113

# Install as editable (-e) or non-editable using pip, with extras (e.g. tests) as desired

# Example installation commands:

# Minimal install (non-editable)

pip install .

# GPU support

pip install .[gpu]

# Full install (editable)

pip install -e .[all]Veuillez noter que les dépendances (spécifiées dans setup.py) sont épinglées pour offrir une expérience stable. Lors de l'installation à partir de la source, ceux-ci peuvent être modifiés, mais cela n'est pas officiellement pris en charge.

Remarque: Dans de nombreux environnements, les bibliothèques FAISS basées sur Conda-Forge fonctionnent sensiblement mieux que celles par défaut installées avec PIP. Pour installer les bibliothèques Faiss de Conda-Forge, utilisez les étapes suivantes:

conda install -c conda-forge faiss=1.7.0 faiss-gpu=1.7.0

setup.py , supprimez les lignes liées à Faish: "faiss-cpu~=1.7.2": ["install", "gpu"],

"faiss-gpu~=1.7.2": ["gpu"],

pip install comme désespéré ci-dessus.Java 11 est requis pour la récupération de BM25. Installez Java comme suit:

conda install -c conda-forge openjdk=11Il y a plusieurs articles de blog des membres de la communauté open source sur la façon dont ils ont utilisé PrimeQA pour leurs besoins. Lisez certains d'entre eux:

Tester Doc

Pour exécuter les tests unitaires, vous devez d'abord installer PrimeQA. Assurez-vous d'installer avec les extras [tests] ou [all] de PIP.

De là, vous pouvez exécuter les tests via Pytest, par exemple:

pytest --cov PrimeQA --cov-config .coveragerc tests/Pour plus d'informations, voir:

| Section | Description |

|---|---|

| ? Documentation | Documentation complète de l'API et tutoriels |

| ? Tour rapide: points d'entrée pour primeqa | Différents points d'entrée pour PrimeQA: récupération d'informations, compréhension en lecture, table et génération de questions |

| ? Tutoriels: cahiers Jupyter | Cahiers pour commencer les tâches QA |

| ? Notes de lecture GPT-3 / Chatgpt | Cahiers pour commencer avec les composants du lecteur GPT-3 / Chatgpt |

| Exemples: appliquer le primeqa sur diverses tâches QA | Exemples de scripts pour les modèles Primeqa à réglage fin sur une gamme de tâches QA |

| ? Partage et téléchargement de modèles | Téléchargez et partagez vos modèles affinés avec la communauté |

| ✅ demande de traction | Demande de traction Primeqa |

| ? Générer de la documentation | Comment fonctionne la documentation |

| ? Service d'orchestrateur Microservice de repos | Code de preuve de concept pour le microservice Orchestrator Primeqa |

| UI d'outils | Démo Ui |

| NLP de Stanford |  | Université de l'Illinois |

| Université de Stuttgart |  | Université de Notre Dame |

| Ohio State University |  | Université Carnegie Mellon |

| Université du Massachusetts |  | Recherche IBM |