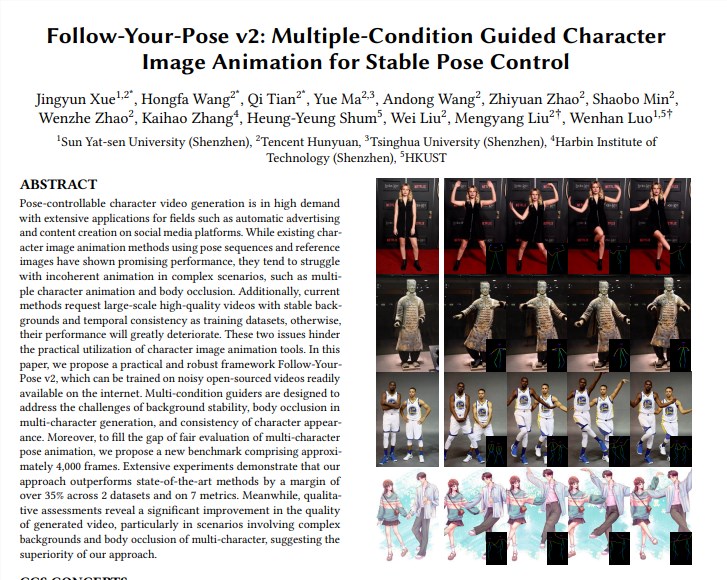

El equipo de Tencent Hunyuan se unió a la Universidad Sun Yat-sen y la Universidad de Ciencia y Tecnología de Hong Kong para lanzar un nuevo modelo de video Tusheng "Follow-Your-Pose-v2", logrando un gran avance en la tecnología de generación de video de una sola persona a varias personas. Este modelo puede manejar fotografías grupales de varias personas y hacer que las personas en las fotos se muevan en el video generado al mismo tiempo, mejorando significativamente la eficiencia y la calidad de la generación de video. Lo más destacado de su tecnología es que admite la generación de acciones de video de varias personas, tiene fuertes capacidades de generalización, se puede entrenar y generar usando fotos/videos de la vida diaria y puede manejar correctamente problemas como la oclusión de personajes. El modelo supera a las técnicas existentes en múltiples conjuntos de datos, lo que demuestra su potente rendimiento y amplias perspectivas de aplicación.

Admite la generación de acciones de video para varias personas: realiza la generación de acciones de video para varias personas con un razonamiento que requiere menos tiempo.

Fuerte capacidad de generalización: se pueden generar videos de alta calidad independientemente de la edad, la vestimenta, la raza, el desorden del fondo o la complejidad de la acción.

Fotos/videos de la vida diaria disponibles: el entrenamiento y la generación de modelos pueden usar fotos/videos de la vida diaria (incluidas instantáneas) o videos, sin buscar imágenes/videos de alta calidad.

Manejar correctamente la oclusión de personajes: ante el problema de que los cuerpos de varios personajes se bloqueen entre sí en una sola imagen, puede generar una imagen de oclusión con la relación correcta de adelante hacia atrás.

Implementación técnica:

El modelo utiliza la "guía de flujo óptico" para introducir información de flujo óptico de fondo, que puede generar una animación de fondo estable incluso cuando la cámara tiembla o el fondo es inestable.

A través de la "Guía de mapa de inferencia" y la "Guía de mapa de profundidad", el modelo puede comprender mejor la información espacial de los personajes en la imagen y las relaciones de posición espacial de múltiples personajes, y resolver efectivamente los problemas de animación de múltiples personajes y oclusión corporal. .

Evaluar y comparar:

El equipo propuso un nuevo punto de referencia Multi-Character, que contiene alrededor de 4000 cuadros de videos de múltiples personajes para evaluar el efecto de la generación de múltiples personajes.

Los resultados experimentales muestran que "Follow-Your-Pose-v2" supera al estado del arte en más del 35% en dos conjuntos de datos públicos (TikTok y discursos TED) y 7 indicadores.

Perspectivas de aplicación:

La tecnología de generación de imágenes a vídeo tiene amplias perspectivas de aplicación en muchas industrias, como la producción de contenidos cinematográficos, la realidad aumentada, la producción de juegos y la publicidad. Es una de las tecnologías de inteligencia artificial que atraerá mucha atención en 2024.

Información adicional:

El equipo Hunyuan de Tencent también anunció una biblioteca de aceleración para el gran modelo de código abierto de gráficos vicencianos (Hunyuan DiT), que mejora en gran medida la eficiencia del razonamiento y acorta el tiempo de generación de gráficos en un 75%.

Se ha reducido el umbral para usar el modelo Hunyuan DiT. Los usuarios pueden llamar al modelo en la biblioteca de modelos oficial de Hugging Face con tres líneas de código.

Dirección del artículo: https://arxiv.org/pdf/2406.03035

Página del proyecto: https://top.aibase.com/tool/follow-your-pose

La aparición del modelo "Follow-Your-Pose-v2" marca un gran avance en la tecnología de vídeo de Tusheng, y vale la pena esperar sus perspectivas de aplicación en muchos campos. En el futuro, con el continuo desarrollo y mejora de la tecnología, se cree que este modelo desempeñará un papel importante en más escenarios y brindará a las personas una experiencia de generación de video más conveniente e inteligente.