OpenAI ha lanzado una nueva generación del modelo de inferencia o3 y su versión optimizada o3-mini, que son los sucesores de la serie o1 y están diseñados para mejorar la precisión de la respuesta a preguntas a través de un pensamiento más profundo. o3 ha logrado grandes avances en el punto de referencia ARC-AGI, demostrando capacidades de resolución de problemas cercanas al nivel humano. o3-mini se centra en la velocidad y la rentabilidad y es especialmente adecuado para tareas de programación. Si bien los modelos de la serie o3 no se lanzarán directamente al público, OpenAI los ha abierto a los investigadores de seguridad para su vista previa.

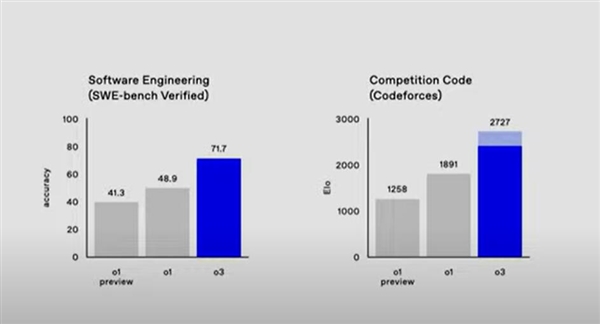

El modelo o3 funciona bien en múltiples puntos de referencia. Por ejemplo, la precisión en el punto de referencia SWE-bench Verified es más de un 20% mayor que o1, y la precisión en las matemáticas de competencia y GPQA Diamond también ha mejorado significativamente. OpenAI también ha introducido un nuevo método de evaluación de seguridad llamado "alineación deliberativa" para garantizar la seguridad del modelo y el cumplimiento de las especificaciones de seguridad. Actualmente, OpenAI se encuentra en pruebas de seguridad externas y ha abierto aplicaciones de acceso temprano.

En términos de programación y resolución de problemas matemáticos, el modelo o3 ha demostrado capacidades notables. En el punto de referencia SWE-bench Verified, la precisión de o3 es de aproximadamente el 71,7%, que es más de un 20% mayor que la del modelo o1. En el Código de Competencia, o3 recibió una puntuación Elo de 2727, mientras que o1 solo recibió 1891. Además, la precisión de o3 en matemáticas de competencia alcanzó el 96,7% y su precisión en GPQA Diamond alcanzó el 87,7%, que es casi un 10% más que o1.

OpenAI también introdujo un nuevo método de evaluación de seguridad: la alineación deliberativa, que es un nuevo paradigma que enseña directamente al modelo las especificaciones de seguridad y puede entrenar el modelo para que recuerde explícitamente las especificaciones y realice un razonamiento preciso antes de responder. Este enfoque se utiliza para alinear los modelos de la serie o de OpenAI y lograr un cumplimiento altamente preciso de las políticas de seguridad de OpenAI.

Actualmente, OpenAI está promoviendo pruebas de seguridad externas y ha abierto solicitudes de acceso temprano en el sitio web. Los solicitantes deben completar un formulario en línea y proporcionar información relevante. Los investigadores seleccionados tendrán acceso a o3 y o3-mini para explorar sus capacidades y contribuir a las evaluaciones de seguridad.

El lanzamiento de los modelos de la serie OpenAI o3 marca una mejora significativa en las capacidades de razonamiento de la inteligencia artificial, y su excelente desempeño en múltiples campos presagia una nueva dirección para el futuro desarrollo de la tecnología de IA. En el futuro, seguiremos prestando atención al progreso y la aplicación de los modelos de la serie o3.