Esta es una lista curada de documentos de "modelo de idioma como servicio (LMAAS)", que es mantenida principalmente por Tianxiang Sun. Alentamos encarecidamente a los investigadores de la PNL que están interesados en este tema a hacer una solicitud de extracción para agregar o actualizar los documentos (ver contribución). ¡Mira este repositorio para ver las últimas actualizaciones!

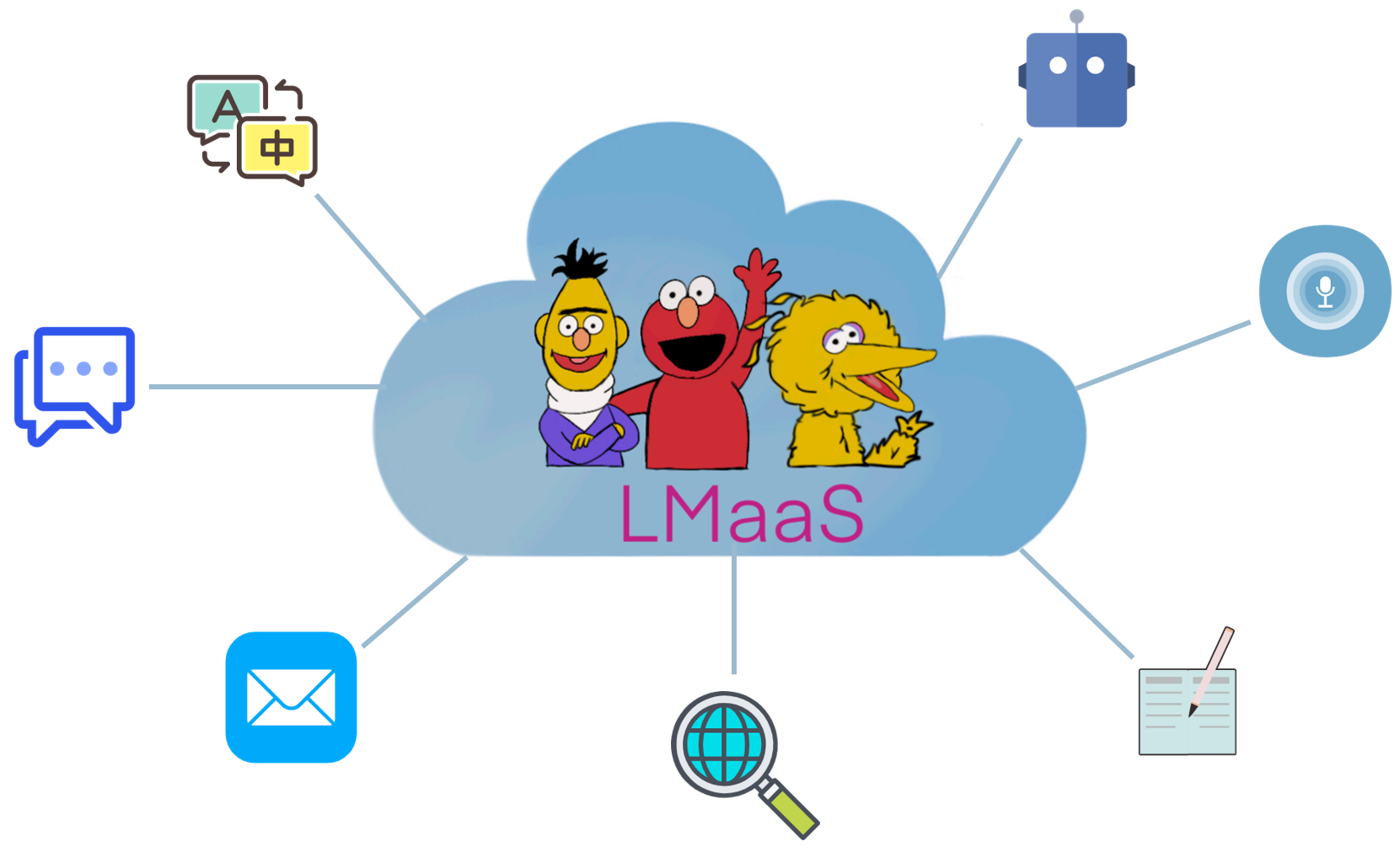

Debido a razones comerciales y costos de ajuste, los modelos de lenguaje grande (LLM) previamente entrenados (LLM) como GPT-3 generalmente se liberan como un servicio en lugar de los pesos del modelo de abastecimiento. Llamamos a este escenario " Language-Model-as-a-Service (LMAAS) " (el término se usa originalmente en nuestro documento ICML'2022). En tal escenario, los usuarios pueden acceder a los poderosos LLM a través de sus API de inferencia. El servicio de LLMS ha alimentado muchos casos de uso (ver Demo de GPT-3). A diferencia del ajuste fino, LMAAS permite que un solo LLM de propósito general cumpla con muchas tareas de diferencia y, por lo tanto, es altamente eficiente en el despliegue. Sin embargo, cómo adaptar las LLM a las tareas apuntar sin acceso a sus parámetros y gradientes es un desafío. Para hacer que los LLM se beneficien un público más amplio, recopilamos documentos que se ajustan a este escenario para facilitar la investigación futura.

¿Qué documentos encajan en el escenario de Lmaas? Consideramos principalmente documentos que adaptan las LLM a las tareas aguas abajo sin acceder a los parámetros del modelo y los gradientes. Aunque LLMS ajustados también puede ser servicios después del despliegue, se limitan a resolver una sola tarea para una audiencia limitada. En nuestro alcance, preferimos servir modelos de propósito general para una variedad de usuarios.

En la literatura existente, hay varias líneas de investigación que encajan en LMAAS:

El límite entre el aprendizaje de texto y en contexto del texto está un poco borrosa. En este repositorio, la categoría de inmediato del texto contiene documentos que no usan muestras etiquetadas, mientras que la categoría de aprendizaje en contexto se compone de documentos que incluyen muestras etiquetadas en las indicaciones.

Nota: Un tema relacionado (y parcialmente superpuesto) es el aprendizaje basado en el aviso , que tiene como objetivo resolver tareas aguas abajo utilizando LLM de propósito general al convertir la entrada y la salida con alguna plantilla y verbalizador, respectivamente. Sin embargo, la mayoría de los trabajos en el aprendizaje rápido requieren el acceso a los parámetros y gradientes del modelo y, por lo tanto, no encajan en nuestro alcance. Para los documentos de aprendizaje basados en el aviso que no son adecuados para LMAA, recomendamos contribuir a otra lista de documentos impresionante: papel de puntaje.

En comparación con las LLM específicas de tareas de ajuste fino, LMAAS tiene las siguientes ventajas:

La abreviatura del trabajo.

La característica clave del trabajo.

El principal entorno experimental de la obra.

¿Modelos de idiomas como bases de conocimiento? EMNLP 2019

Fabio Petroni, Tim Rocktäschel, Patrick Lewis, Anton Bakhtin, Yuxiang Wu, Alexander H. Miller, Sebastian Riedel . [PDF] [Código]

¿Cómo podemos saber lo que saben los modelos de idiomas? TACL 2020

Zhengbao Jiang, Frank F. Xu, Jun Araki, Graham Neubig . [PDF] [Código]

Los modelos de idiomas son alumnos de pocos disparos. Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, ADATRES Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei . [PDF]

Adaptando modelos de lenguaje para el aprendizaje de disparo cero mediante meta-ajuste en el conjunto de datos y colecciones de inmediato . Hallazgos de EMNLP 2021

Ruiqi Zhong, Kristy Lee, Zheng Zhang, Dan Klein . [PDF] [Código]

Los modelos de idiomas finetos son alumnos de cero disparos . ICLR 2022

Jason Wei, Maarten Bosma, Vincent Y. Zhao, Kelvin Guu, Adams Wei Yu, Brian Lester, Nan du, Andrew M. Dai, Quoc V. LE . [PDF] [Código]

La capacitación impulsada por múltiples tareas permite la generalización de tareas de disparo cero . ICLR 2022

Victor Sanh, Albert Webson, Colin Raffel, Stephen H. Bach, Lintang Sutawika, Zaid Alyafeai, Antoine Chaffin, Arnaud Stiegler, Teven Le Scao, Arun Raja, Manan Dey, M Saiful Bari, Canwen Xu, Urmish Thakker, Shanya Sharma, Eliza Szczechla, Taewoon Kim, Gunjan Chhablani, Nihal Nayak, Debajyoti Datta, Jonathan Chang, Mike Tian-Jian Jiang, Han Wang, Matteo Manica, Sheng Shen, Zheng Xin Yong, Harshit Pandey, Rachel Bawden, Thomas Wang, Trishala NEERAZJ, JOSHEEST , Andrea Santilli, Thibault Fevry, Jason Alan Fries, Ryan Teehan, Tali Bers, Stella Biderman, Leo Gao, Thomas Wolf, Alexander M. Rush . [PDF] [Código]

Modelos de lenguaje de capacitación para seguir las instrucciones con comentarios humanos . Preimpresión 2022.3

Long Ouyang, Jeff Wu, Xu Jiang, Diogo Almeida, Carroll L. Wainwright, Pamela Mishkin, Chong Zhang, Sandhini Agarwal, Katarina Slama, Alex Ray, John Schulman, Jacob Hilton, Fraser Kelton, Luke Miller, Maddie Simens, Amanda Askell, Peter Welinder, Paul Christiano, Jan Leike, Ryan Lowe . [PDF] [Código]

Los modelos de idiomas grandes son razonadores de cero disparos . Preimpresión 2022.6

Takeshi Kojima, Shixiang Shane Gu, Machel Reid, Yutaka Matsuo, Yusuke Iwasawa . [PDF] [Código]

Pregunta de video de disparo cero a través de modelos de lenguaje bidireccional congelado . Preimpresión 2022.6

Antoine Yang, Antoine Miech, Josef Sivic, Ivan Laptev, Cordelia Schmid . [PDF] [Código]

Los modelos de lenguaje son interfaces de uso general . Preimpresión 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming Ma, Furu Wei . [PDF] [Código]

Generación de solicitud a nivel de repositorio para grandes modelos de código de idioma. Preimpresión 2022.6

Disha Shrivastava, Hugo Larochelle, Daniel Tarlow [PDF] [Código], 2022.6

Ignore el aviso anterior: técnicas de ataque para modelos de lenguaje. Mejor premio de papel @ Neurips ML Taller de seguridad 2022.

Fábio Pérez, Ian Ribeiro [PDF] [Proyecto], 2022.11

Los modelos de idiomas son alumnos de pocos disparos. Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, ADATRES Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei . [PDF]

Calibrar antes de su uso: Mejora del rendimiento de pocos disparos de los modelos de idiomas . ICML 2021

Tony Z. Zhao, Eric Wallace, Shi Feng, Dan Klein, Sameer Singh . [PDF] [Código]

Una explicación del aprendizaje en contexto como inferencia bayesiana implícita . ICLR 2022

Sang Michael Xie, Aditi Raghunathan, Percy Liang, Tengyu MA . [PDF] [Código]

La cadena de pensamiento provoca un razonamiento en modelos de idiomas grandes . Preimpresión 2022.1

Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Brian Ichter, Fei Xia, Ed Chi, Quoc Le, Denny Zhou . [PDF]

Generalización de la tarea cruzada a través de instrucciones de crowdsourcing del lenguaje natural . ACL 2022

Swaroop Mishra, Daniel Khashabi, Chitta Baral, Hannaneh Hajishirzi . [PDF] [Código]

Solicitudes fantásticamente ordenadas y dónde encontrarlas: superar la sensibilidad de pedido de pocos disparos . ACL 2022

Yao Lu, Max Bartolo, Alastair Moore, Sebastian Riede, Pontus Stenetorp . [PDF]

Modelo de lenguaje de canal ruidoso solicitar la clasificación de texto de pocos disparos . ACL 2022

Sewon Min, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer . [PDF] [Código]

Meta-aprendizaje a través del modelo de idioma sintonización en contexto . ACL 2022

Yanda Chen, Ruiqi Zhong, Sheng Zha, George Karypis, He . [PDF] [Código]

¿Qué hace buenos ejemplos en contexto para GPT-3? Deelio@ACL 2022

Jiachang Liu, Dinghan Shen, Yizhe Zhang, Bill Dolan, Lawrence Carin, Weizhu Chen . [PDF]

Aprender a recuperar indicaciones para el aprendizaje en contexto . NAACL 2022

Ohad Rubin, Jonathan Herzig, Jonathan Berant . [PDF] [Código]

Metaicl: Aprender a aprender en contexto . NAACL 2022

Sewon Min, Mike Lewis, Luke Zettlemoyer, Hannaneh Hajishirzi . [PDF] [Código]

Mejora del aprendizaje de pocos disparos en contexto a través de la capacitación auto-supervisada . NAACL 2022

Mingda Chen, Jingfei Du, Ramakanth Pasunuru, Todor Mihaylov, Srini Iyer, Veselin Stoyanov, Zornitsa Kozareva . [PDF]

Aprendizaje en contexto autogenerado: aprovechando los modelos de lenguaje autoregresivo como generador de demostración . LPLM@NAACL 2022

Hyuhng Joon Kim, Hyunsoo Cho, Junyeob Kim, Taeuk Kim, Kang Min Yoo, Sang-Goo Lee . [PDF]

Repensar el papel de las demostraciones: ¿Qué hace que el aprendizaje en contexto funcione? Preimpresión 2022.2

Sewon Min, Xinxi Lyu, Ari Holtzman, Mikel Artetxe, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer . [PDF] [Código]

Aprendizaje en contexto para el seguimiento del estado de diálogo de pocos disparos. Preimpresión 2022.3

Yushi Hu, Chia-Hsuan Lee, Tianbao Xie, Tao Yu, Noah A. Smith, Mari Ostendorf . [PDF] [Código]

La autoconsistencia mejora el razonamiento de la cadena de pensamiento en los modelos de idiomas . Preimpresión 2022.3

Xuezhi Wang, Jason Wei, Dale Schuurmans, Quoc Le, Ed Chi, Denny Zhou . [PDF]

Estrella: razonador autodidacta del razonamiento de arranque con razonamiento . Preimpresión 2022.3

Eric Zelikman, Yuhuai Wu, Noah D. Goodman . [PDF]

Generalización de evaluación comparativa a través de instrucciones en contexto en más de 1,600 tareas de lenguaje . Preimpresión 2022.4

Yizhong Wang, Swaroop Mishra, Pegah Alipoormolabashi, Yeganeh Kordi, Amirreza Mirzaei, Anjana Arunkumar, Arjun Ashok, Arut Selvan Dhanasekaran, Atharva Naik, David Stap, Eshaan Pathak, Giannis Karamanolakis, Haizhi Gary Gary, Ishan Stap, Eshaan, eshaan Karamanolakis, Haizhi Gared Ishani Mondal, Jacob Anderson, Kirby Kuznia, Krima Doshi, Maitreya Patel, Kuntal Kumar Pal, Mehrad Moradshahi, Mihir Parmar, Mirali Purohit, Neeraj Varshney, Phani Rohitha Kaza, Pulkit Verma, Ravsehaj Singh Puri, Rushang Karia, Shailaja Keyur Sampat, Savan Doshi, Siddhartha Mishra, Sujan Reddy, Sumanta Patro, Tanay Dixit, Xudong Shen, Chitta Baral, Yejin Choi, Noah A. Smith, Hannaneh Hajishirzi, Daniel Khashabi . [PDF] [Código]

¿Pueden los modelos de idiomas aprender de las explicaciones en contexto? . Preimpresión 2022.4

Andrew K. Lampinen, Ishita Dasgupta, Stephanie Cy Chan, Kory Matthewson, Michael Henry Tessler, Antonia Creswell, James L. McClelland, Jane X. Wang, Felix Hill . [PDF]

Las etiquetas de verdad en tierra son importantes: una mirada más profunda a las demostraciones de etiqueta de entrada . Preimpresión 2022.5

Junyeob Kim, Hyuhng Joon Kim, Hyunsoo Cho, Hwiyeol JO, Sang-Woo Lee, Sang-Goo Lee, Kang Min Yoo, Taeuk Kim . [PDF]

La falta de fiabilidad de las explicaciones en el aprendizaje de pocos disparos en contexto . Preimpresión 2022.5

XI YE, Greg Durrett . [PDF]

La solicitud de menos a la mayoría permite un razonamiento complejo en modelos de idiomas grandes . Preimpresión 2022.5

Denny Zhou, Nathanael Schärli, Le Hou, Jason Wei, Nathan Scales, Xuezhi Wang, Dale Schuurmans, Olivier Bousquet, Quoc Le, Ed Chi . [PDF]

Información de Maieutic: razonamiento lógicamente consistente con explicaciones recursivas . Preimpresión 2022.5

Jaehun Jung, Lianhui Qin, Sean Welleck, Feeze Brahman, Chandra Bhagavatula, Ronan Le Bras, Yejin Choi . [PDF]

Con el avance de hacer que los modelos de idiomas sean mejores razonadores . Preimpresión 2022.6

Yifei Li, Zeqi Lin, Shizhuo Zhang, Qiang Fu, Bei Chen, Jian-Guang Lou, Weizhu Chen . [PDF] [Código]

Habilidades emergentes de modelos de idiomas grandes . Preimpresión 2022.6

Jason Wei, Yi Tay, Rishi Bommasani, Colin Raffel, Barret Zoph, Sebastian Borgeaud, Dani Yogatama, Maarten Bosma, Denny Zhou, Donald Metzler, Ed H. Chi, Tatsunori Hashimoto, Oriol Vinyals, Percy Liang, Jeff Dean, William Fedus . [PDF]

Los modelos de lenguaje son interfaces de uso general . Preimpresión 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming Ma, Furu Wei . [PDF] [Código]

¿Qué pueden aprender los transformadores en contexto? Un estudio de caso de clases de funciones simples . Preimpresión 2022.8

Shivam Garg, Dimitris Tsipras, Percy Liang, Gregory Valiant . [PDF] [Código]

Aprendiendo destilando el contexto . Preimpresión 2022.9

Charlie Snell, Dan Klein, Ruiqi Zhong . [PDF]

Modelos de lenguaje vinculante en idiomas simbólicos . Preimpresión 2022.10

Zhoujun Cheng*, Tianbao Xie*, Peng Shi, Chengzu Li, Rahul Nadkarni, Yushi Hu, Caiming Xiong, Dragomir Radev, Mari Ostendorf, Luke Zettleemoyer, Noah A. Smith, Tao Yu . [PDF] [Código] [Sitio web]

Preservar la capacidad de aprendizaje en contexto en el modelo de lenguaje grande ajustado . Preimpresión 2022.11

Yihan Wang, Si SI, Daliang Li, Michal Lukasik, Felix Yu, Cho-Jui Hsieh, Inderjit S Dhillon, Sanjiv Kumar . [PDF]

Enseñanza de razonamiento algorítmico a través del aprendizaje en contexto . Preimpresión 2022.11

Hattie Zhou, Azade Nova, Hugo Larochelle, Aaron Courville, Behnam Neyshabur, Hanie Sedghi . [PDF]

¿Qué algoritmo de aprendizaje está aprendiendo en contexto? Investigaciones con modelos lineales . Preimpresión 2022.11

Ekin Akyürek, Dale Schuurmans, Jacob Andreas, Tengyu MA, Denny Zhou . [PDF]

Ajuste de la caja negra para el model de lenguaje como servicio . ICML 2022

Tianxiang Sun, Yunfan Shao, Hong Qian, Xuanjing Huang, Xipeng Qiu. [PDF] [Código]

Aprendizaje indicador de la caja negra para modelos de idiomas previamente capacitados . TMLR 2023.2

Shizhe Diao, Xuechun Li, Yong Lin, Zhichao Huang, Tong Zhang . [PDF]

ADCURSES: búsqueda de instrucciones basada en edición sin gradiente para solicitar grandes modelos de idioma . Preimpresión 2022.3

Archiki Prasad, Peter Hase, Xiang Zhou, Mohit Bansal . [PDF] [Código]

Peque incrustación de disparo a la generación de respuesta controlable . Preimpresión 2022.6

Hsuan Su, Pohan Chi, Shih-Cheng Huang, Chung Ho Lam, Saurav Sahay, Shang-Tse Chen, Hung-Yi Lee . [PDF]

BBTV2: hacia un futuro sin gradiente con modelos de idiomas grandes . EMNLP 2022

Tianxiang Sun, Zhengfu He, Hong Qian, Yunhua Zhou, Xuanjing Huang, Xipeng Qiu . [PDF] [Código]

RLPROMPT: Optimización de las indicaciones de texto discretos con el aprendizaje de refuerzo . EMNLP 2022

Mingkai Deng, Jianyu Wang, Cheng-Ping Hsieh, Yihan Wang, Han Guo, Tianmin Shu, Meng Song, Eric P. Xing, Zhiting Hu . [PDF] [Código]

Ajuste de clip: hacia el aprendizaje rápido sin derivado con una mezcla de recompensas . Hallazgos de EMNLP 2022

Yekun Chai, Shuohuan Wang, Yu Sun, Hao Tian, Hua Wu, Haifeng Wang . [PDF]

Tempera: edición rápida del tiempo de prueba a través del aprendizaje de refuerzo . Preimpresión 2022.11

Tianjun Zhang, Xuezhi Wang, Denny Zhou, Dale Schuurmans, Joseph E. González. [PDF] [Código]

ARRACHBOOSTING: Clasificación de texto de caja negra con diez pases hacia adelante . Preimpresión 2022.12

Bairu Hou, Joe O'Connor, Jacob Andreas, Shiyu Chang, Yang Zhang . [PDF]

Prerrevenimiento multitarea de aviso modular para el aprendizaje chino de pocos disparos . ACL 2023

Tianxiang Sun, Zhengfu He, Qin Zhu, Xipeng Qiu, Xuanjing Huang . [PDF]

Cuando el descenso de gradiente cumple con la optimización sin derivado: una coincidencia hecha en el escenario de caja negra . ACL 2023

Chengcheng Han, Liqing Cui, Renyu Zhu, Jianing Wang, Nuo Chen, Qiushi Sun, Xiang Li, Ming Gao . [PDF]

Haga un ajuste de caja negra basada en el aviso colorida: impulso de generalización del modelo desde tres perspectivas ortogonales . LREC-Color 2024

Qiushi Sun, Chengcheng Han, Nuo Chen, Renyu Zhu, Jingyang Gong, Xiang Li, Ming Gao . [PDF]

Para sintonizar o no sintonizar? Adaptar representaciones previas a las tareas diversas . Repl4nlp@ACL 2019

Matthew E. Peters, Sebastian Ruder, Noah A. Smith . [PDF]

¿Pueden las explicaciones ser útiles para calibrar modelos de caja negra? ACL 2022

XI YE, Greg Durrett . [PDF] [Código]

La capacitación mejora el aprendizaje basado en el aviso para modelos de idiomas grandes . ICML 2022

Hunter Lang, Monica Agrawal, Yoon Kim, David Sontag . [PDF]

Ajunte en Y: un paradigma de sintonización eficiente para modelos previamente capacitados a gran escala a través del aprendizaje de representación de etiquetas . Preimpresión 2022.2

Yitao Liu, Chenxin AN, Xipeng Qiu . [PDF]

LST: Ejunte lateral de escalera para el aprendizaje de transferencia eficiente de parámetros y memoria . Neurips 2022

Yi-Lin Sung, Jaemin Cho, Mohit Bansal . [PDF] [Código]

Ajuste del decodificador: comprensión de lenguaje eficiente como decodificación . Preimpresión 2022.12

Ganqu Cui, Werao Li, Ning Ding, Longtao Huang, Zhiyuan Liu, Maosong Sun. [PDF]

Generación de conjuntos de datos con modelos de lenguaje previos a la aparición . EMNLP 2021

Timo Schick, Hinrich Schütze . [PDF] [Código]

GPT3MIX: Aprovechando modelos de lenguaje a gran escala para el aumento de texto . Hallazgos de EMNLP 2021

Kang Min Yoo, Dongju Park, Jaewook Kang, Sang-Woo Lee, Woomyeong Park . [PDF] [Código]

Conocimiento generado por el conocimiento para el razonamiento de sentido común . ACL 2022

Jiacheng Liu, Alisa Liu, Ximing Lu, Sean Welleck, Peter West, Ronan Le Bras, Yejin Choi, Hannaneh Hajishirzi . [PDF] [Código]

Zerogen: aprendizaje eficiente de disparo cero a través de la generación de conjuntos de datos . EMNLP 2022

Jiacheng Ye, Jiahui Gao, Qintong Li, Hang Xu, Jiangtao Feng, Zhiyong Wu, Tao Yu, Lingpeng Kong . [PDF] [Código]

Zerogen+: Generación de datos de alta calidad autoguiada en aprendizaje eficiente de disparo cero . Preimpresión 2022.2

Jiahui Gao, Renjie PI, Yong Lin, Hang Xu, Jiacheng Ye, Zhiyong Wu, Xiaodan Liang, Zhenguo Li, Lingpeng Kong . [PDF]

Augesc: Aumento del diálogo con modelos de idiomas grandes para la conversación de apoyo emocional . Hallazgos de ACL 2023

Chujie Zheng, Sahand Sabour, Jiaxin Wen, Zheng Zhang, Minlie Huang . [PDF]

Generación de datos de capacitación con modelos de lenguaje: hacia la comprensión del lenguaje de disparo cero . Neurips 2022

Yu Meng, Jiaxin Huang, Yu Zhang, Jiawei Han [PDF] [Código]

? En primer lugar, ¡gracias por tomarse el tiempo para contribuir! ?

Pasos para contribuir:

PaperNumber en la parte superior de la página en consecuencia y envíe su solicitud de extracción. Recomendamos dar una explicación muy breve por qué cree que se debe agregar o cambiar un documento.No se preocupe si pone algo mal, los arreglaremos para usted. ¡Solo contribuye y promueve su increíble trabajo aquí!

Además de los siguientes contribuyentes que presentaron solicitudes de extracción, también nos gustaría agradecer a Ohad Rubin y Kang Min Yoo por recomendar los documentos.