Answer.AI und LightOn haben gemeinsam das Open-Source-Sprachmodell ModernBERT veröffentlicht, das eine wesentliche Verbesserung gegenüber Google BERT darstellt und Geschwindigkeit, Effizienz und Qualität deutlich verbessert hat. ModernBERT verarbeitet viermal schneller als BERT, benötigt weniger Speicher und kann Text mit bis zu 8192 Token verarbeiten, was 16-mal schneller ist als bestehende Modelle. Außerdem wurden erstmals bahnbrechende Fortschritte bei der Codierung von Programmiercode erzielt und im StackOverflow-Q&A-Datensatz über 80 Punkte erzielt, was einen neuen Rekord darstellt. Noch wichtiger ist, dass ModernBERT die Kosten für die Textverarbeitung in großem Maßstab erheblich senkt und auf gewöhnlicher Consumer-Hardware ausgeführt werden kann, wodurch es kostengünstiger ist als Modelle wie GPT-4.

Das Design von ModernBERT ermöglicht die Verarbeitung von Texten mit einer Länge von bis zu 8192 Token, was eine 16-fache Verbesserung gegenüber der typischen Beschränkung bestehender Codierungsmodelle auf 512 Token darstellt. Darüber hinaus ist ModernBERT das erste umfassend trainierte Programmiercode-Kodierungsmodell, das im StackOverflow-Q&A-Datensatz eine Punktzahl von über 80 erreicht und damit einen neuen Rekord für Kodierungsmodelle aufstellt.

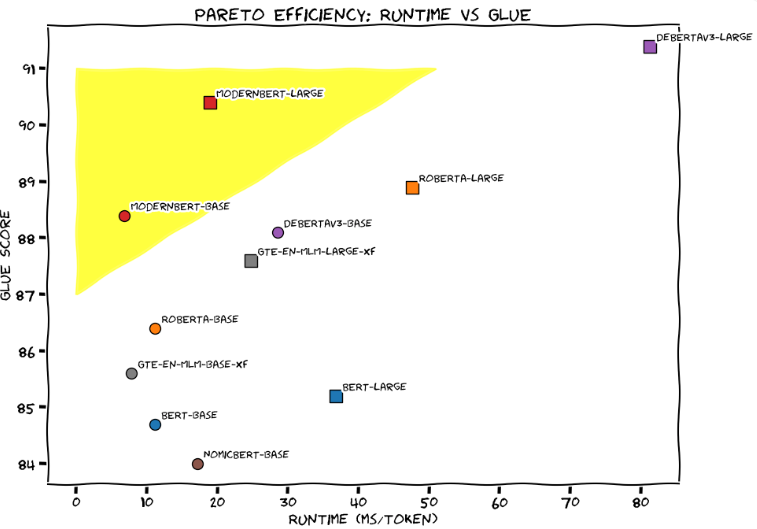

Bei der General Language Understanding Evaluation (GLUE) erreichte ModernBERT-Large mit einer Verarbeitungszeit von etwa 20 Millisekunden pro Token und einer Punktzahl von 90 das beste Gleichgewicht zwischen Verarbeitungsgeschwindigkeit und Genauigkeit. Das Entwicklungsteam verglich ModernBERT anschaulich mit einem getunten Honda Civic und betonte, dass es im täglichen Einsatz zuverlässig und effizient sei.

Im Vergleich zu bestehenden groß angelegten Sprachmodellen wie GPT-4 reduziert ModernBERT die Kosten der groß angelegten Textverarbeitung erheblich. GPT-4 kostet ein paar Cent pro Abfrage, während ModernBERT lokal läuft, schneller und günstiger ist. Als das FineWeb Edu-Projekt beispielsweise 15 Milliarden Tags filterte, beliefen sich die Kosten für die Verwendung des BERT-Modells auf 60.000 US-Dollar, und selbst für die Verwendung des Gemini Flash-Decoders von Google betrugen die Kosten mehr als 1 Million US-Dollar.

Das Entwicklungsteam sagt, dass ModernBERT für eine Vielzahl praktischer Anwendungen gut geeignet ist, darunter RAG-Systeme (Retrieval-Augmented Generation), Codesuche und Inhaltsüberprüfung. Im Gegensatz zu GPT-4, das spezielle Hardware erfordert, kann ModernBERT effektiv auf gewöhnlichen Consumer-Gaming-GPUs ausgeführt werden.

Derzeit ist ModernBERT in zwei Versionen verfügbar: Das Basismodell enthält 139 Millionen Parameter und die große Version enthält 395 Millionen Parameter. Beide Versionen sind jetzt auf Hugging Face veröffentlicht und Benutzer können bestehende BERT-Modelle direkt durch sie ersetzen. Das Entwicklungsteam plant, nächstes Jahr eine größere Version auf den Markt zu bringen, es gibt jedoch keine Pläne für multimodale Funktionen. Um die Entwicklung neuer Apps zu fördern, starten sie außerdem einen Wettbewerb, bei dem die fünf besten Moderatoren mit 100 US-Dollar und einem sechsmonatigen Hugging Face Pro-Abonnement belohnt werden.

Seit Google BERT im Jahr 2018 eingeführt hat, ist das Modell mit mehr als 68 Millionen monatlichen Downloads auf HuggingFace eines der beliebtesten Sprachmodelle.

Projekteingang: https://huggingface.co/blog/modernbert

Höhepunkte:

ModernBERT ist viermal schneller als BERT und kann Texte mit einer Länge von bis zu 8192 Token verarbeiten.

Im Vergleich zu GPT-4 sind die Kosten von ModernBERT bei der Textverarbeitung in großem Maßstab erheblich geringer und der Betrieb effizienter.

Dieses Modell ist besonders gut bei der Verarbeitung von Programmiercode und erzielte im StackOverflow-Q&A-Datensatz eine Punktzahl von über 80, was einen neuen Rekord aufstellt.

Kurz gesagt: Die Open-Source-Version von ModernBERT bietet Entwicklern eine effiziente, wirtschaftliche und leistungsstarke Auswahl an Sprachmodellen. Sie bietet erhebliche Vorteile in Bezug auf Geschwindigkeit, Effizienz und die Fähigkeit, lange Texte zu verarbeiten, und soll die innovative Entwicklung weiterer KI-Anwendungen fördern . Wir freuen uns auf zukünftige Updates und weitere Anwendungen.