Dies ist eine inoffizielle Pytorch-Implementierung eines Papiers, der in Echtzeit mit adaptiver Instanznormalisierung [Huang+, ICCV2017] in Echtzeit umgesetzt wird. Ich bin der ursprünglichen Implementierung in Torch der Autoren sehr dankbar, was sehr nützlich ist.

Bitte installieren Sie die Anforderungen per pip install -r requirements.txt

(Optional für das Training)

Laden Sie Decoder.PTH / vgg_normalized.PTH von der Veröffentlichung herunter und setzen Sie sie unter models/ .

Verwenden Sie --content und --style , um den jeweiligen Weg zum Inhalt und zum Stil zu bieten.

CUDA_VISIBLE_DEVICES=<gpu_id> python test.py --content input/content/cornell.jpg --style input/style/woman_with_hat_matisse.jpg

Sie können den Code auch über Verzeichnisse von --content_dir und --style_dir ausführen. Es speichert jede mögliche Kombination von Inhalten und Stilen im Ausgabeverzeichnis.

CUDA_VISIBLE_DEVICES=<gpu_id> python test.py --content_dir input/content --style_dir input/style

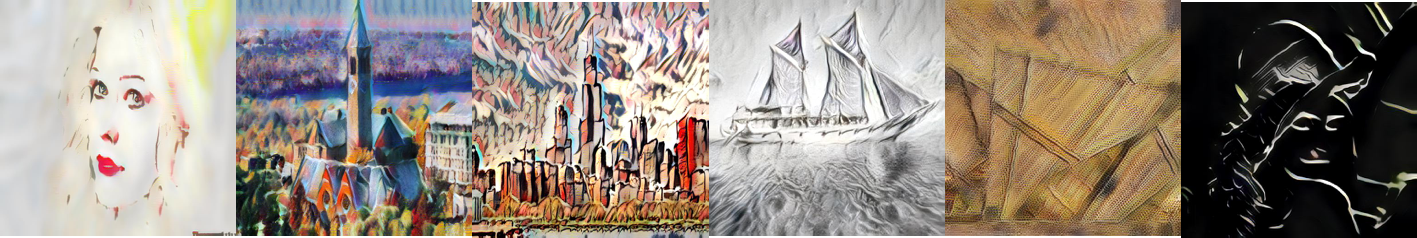

Dies ist ein Beispiel für das Mischen von vier Stilen durch Angeben von --style und --style_interpolation_weights Option.

CUDA_VISIBLE_DEVICES=<gpu_id> python test.py --content input/content/avril.jpg --style input/style/picasso_self_portrait.jpg,input/style/impronte_d_artista.jpg,input/style/trial.jpg,input/style/antimonocromatismo.jpg --style_interpolation_weights 1,1,1,1 --content_size 512 --style_size 512 --crop

Einige andere Optionen:

--content_size : Neue (minimale) Größe für das Inhaltsbild. Halten Sie die ursprüngliche Größe auf 0.--style_size : Neue (minimale) Größe für das Content-Bild. Halten Sie die ursprüngliche Größe auf 0.--alpha : Passen Sie den Grad der Stylisation an. Es sollte ein Wert zwischen 0,0 und 1,0 sein (Standard).--preserve_color : Erhalten Sie die Farbe des Content-Bildes. Verwenden Sie --content_dir und --style_dir um das jeweilige Verzeichnis für Inhalts- und Stilbilder bereitzustellen.

CUDA_VISIBLE_DEVICES=<gpu_id> python train.py --content_dir <content_dir> --style_dir <style_dir>

Weitere Details und Parameter finden Sie unter der Option "Help".

Ich teile das von diesem Code als iter_1000000.pth ausgebildete Modell bei der Veröffentlichung.