Der Chat mit PDF -App ist eine Python -Anwendung, mit der Sie mit einem PDF -Dokumenten chatten können. Sie können Fragen zur PDF mit natürlicher Sprache stellen, und die Anwendung bietet relevante Antworten basierend auf dem Inhalt der Dokumente. Diese App verwendet ein Sprachmodell, um genaue Antworten auf Ihre Abfragen zu generieren. Bitte beachten Sie, dass die App nur auf Fragen im Zusammenhang mit dem geladenen PDF beantwortet wird.

Um den Chat mit PDF -App zu installieren, befolgen Sie bitte die folgenden Schritte:

Laden Sie die Ollama -Bibliothek herunter

curl https://ollama.ai/install.sh | sh

Ziehen Sie die Chat -Modelle an, die wir verwenden werden, in diesem Fall werden wir LLAMA2, Mistral und Gemma verwenden

ollama pull llama2

ollama pull mistral

ollama pull gemma

Erstellen Sie eine neue Umgebung mit Python 3.9 und aktivieren Sie sie. In diesem Fall werden wir Conda verwenden

conda create -n cwp python=3.9

conda activate cwp

Klonen Sie das Repository in Ihre lokale Maschine.

git clone https://github.com/jorge-armando-navarro-flores/chat_with_PDF.git

cd chat_with_PDF

Installieren Sie die erforderlichen Abhängigkeiten, indem Sie den folgenden Befehl ausführen:

pip install -r requirements.txt

Befolgen Sie die folgenden Schritte, um den Chat mit PDF -App zu verwenden:

Führen Sie die main.py -Datei mit der Streamlit CLI aus. Führen Sie den folgenden Befehl aus:

python3 main.py

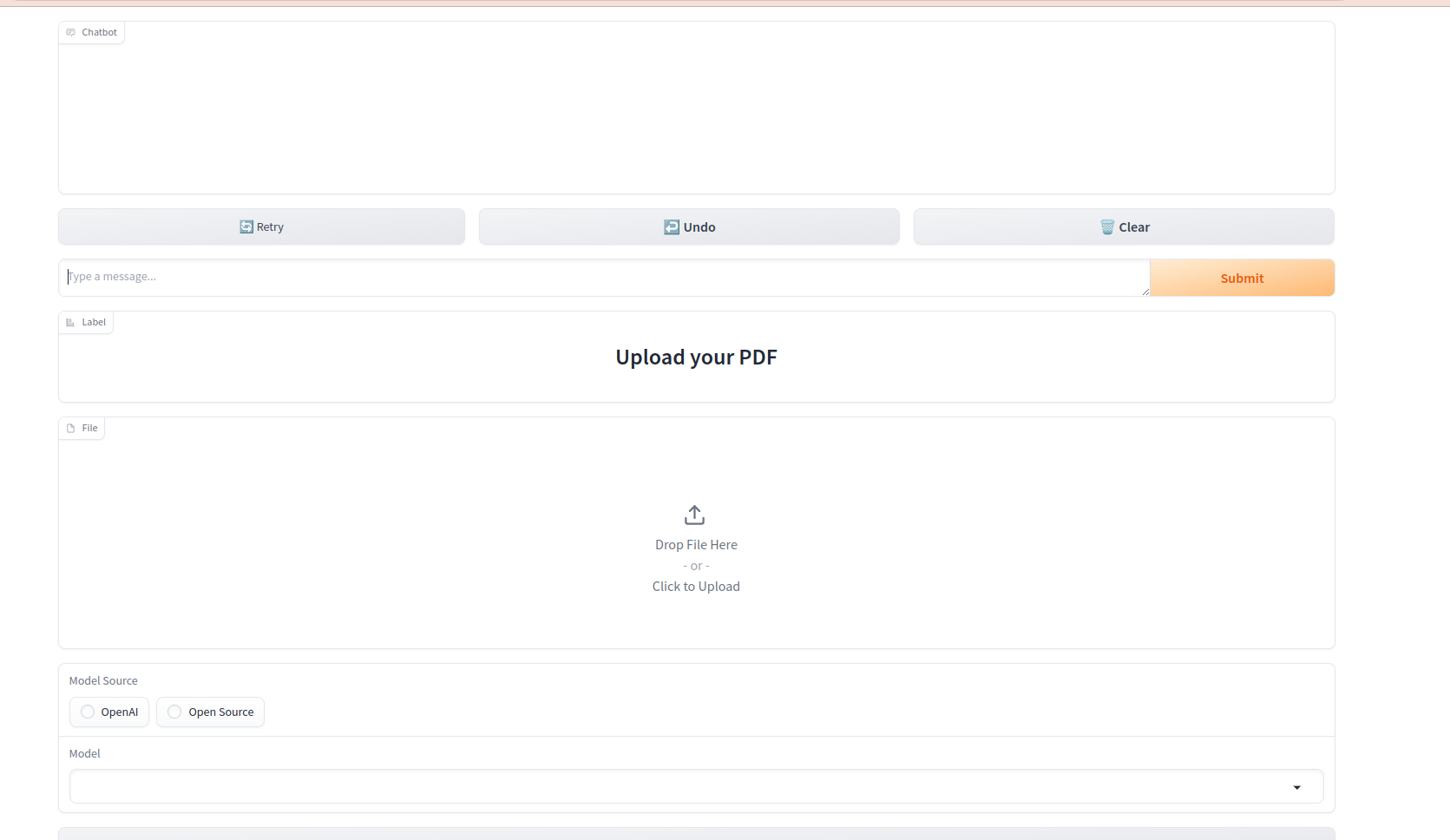

Die Anwendung startet in Ihrem Standard -Webbrowser und zeigt die Benutzeroberfläche an.

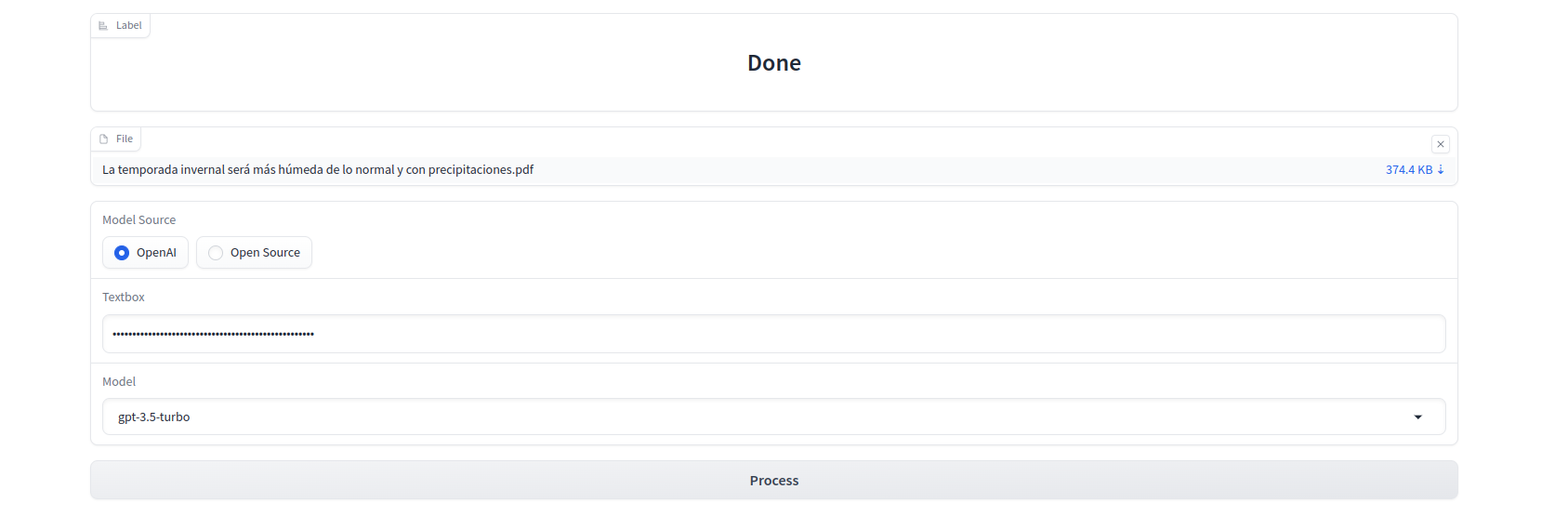

Laden Sie Ihr PDF in die App, indem Sie den angegebenen Anweisungen befolgen.

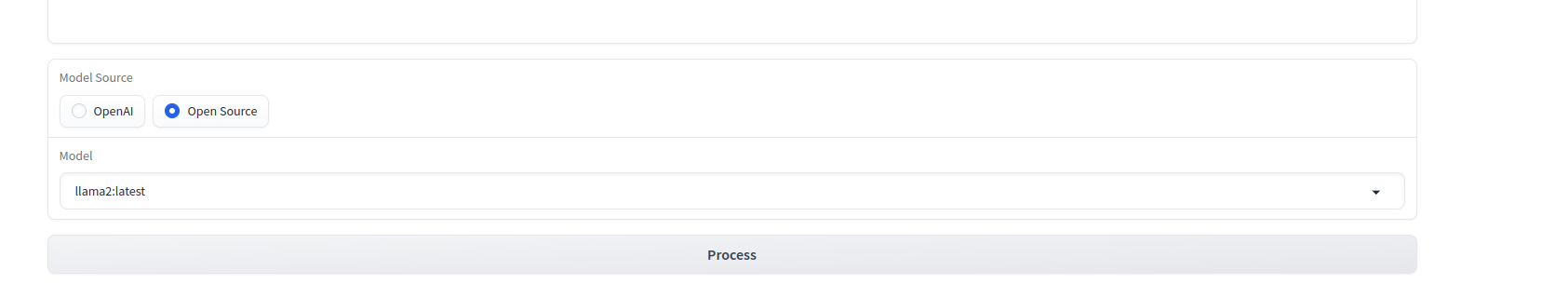

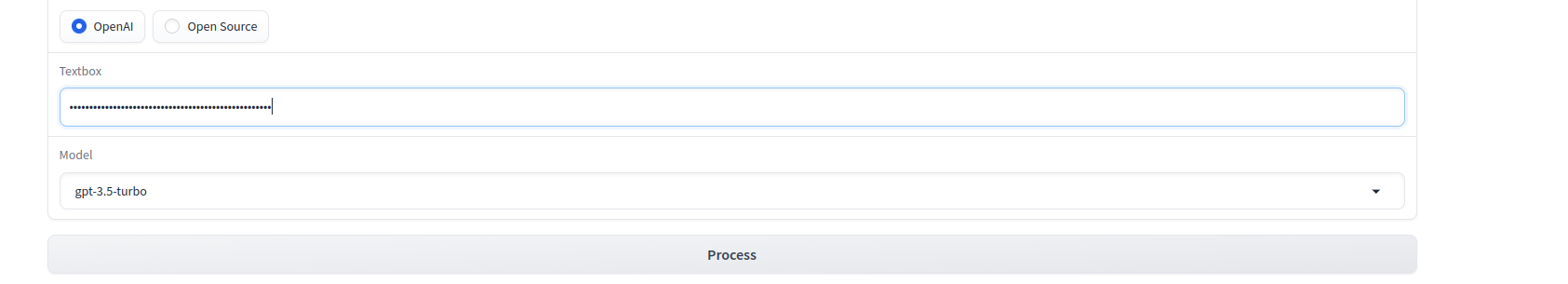

Wählen Sie LLM Quelle.

Wenn Sie OpenAI -Quelle wählen, müssen Sie Ihren OpenAI_API_Key angeben. Sie können es hier bekommen

Klicken Sie auf die Schaltfläche Prozess und Wartenbezeichnung sagen erledigt

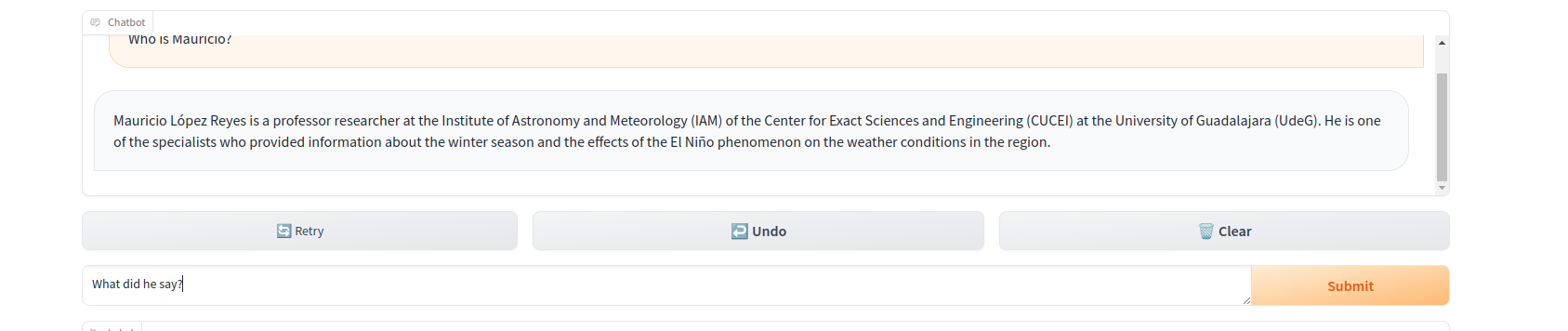

Stellen Sie Fragen in der natürlichen Sprache zum geladenen PDF mithilfe der Chat -Schnittstelle.