Booster laut Merriam-Webster Dictionary:

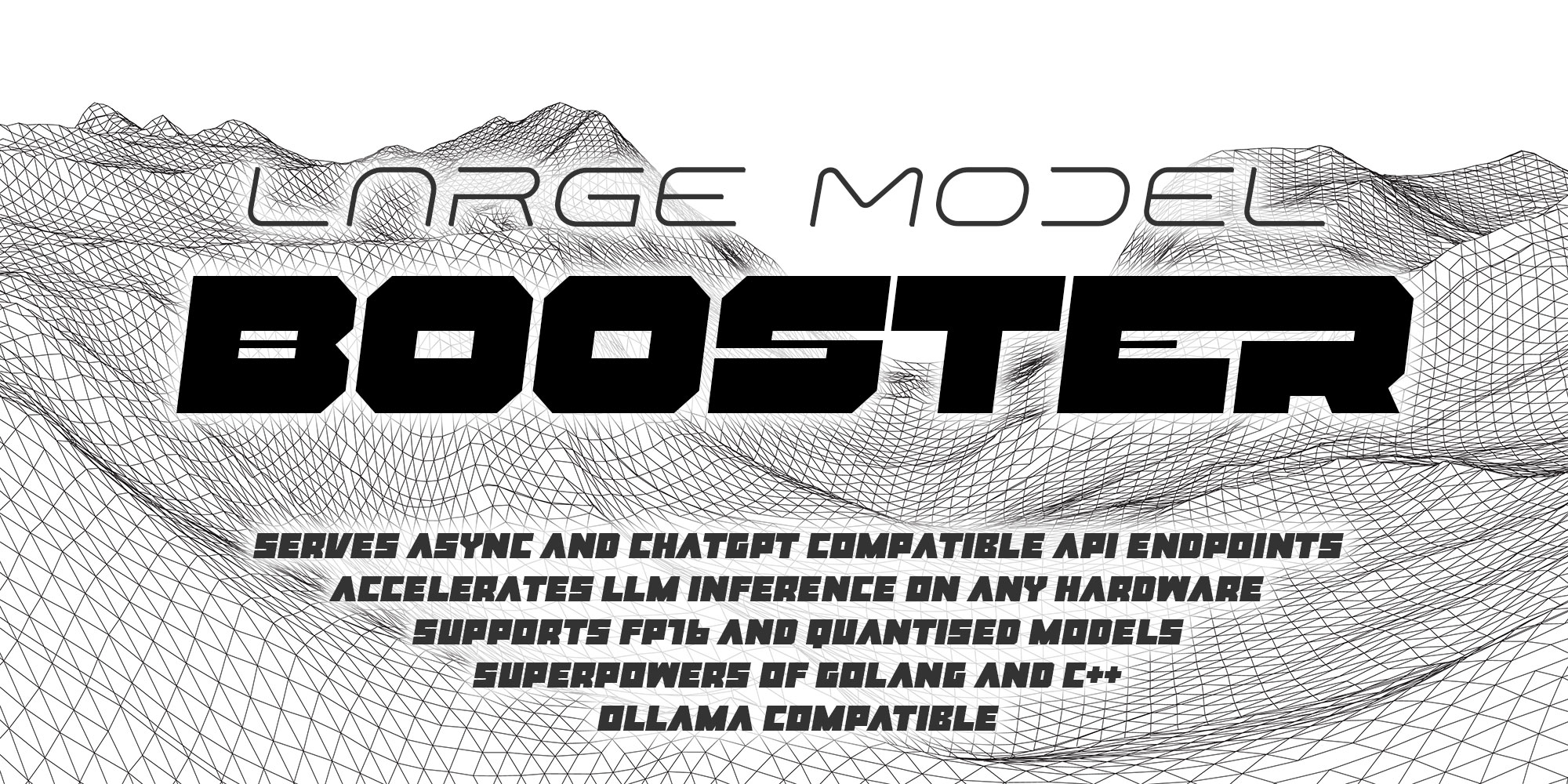

Large Model Booster zielt darauf ab, ein einfaches und mächtiges LLM -Inferenzbeschleuniger zu sein, sowohl für diejenigen, die GPTs in der Produktionsumgebung skalieren müssen, oder nur mit Modellen selbst zu experimentieren.

Innerhalb des ersten Monats von Llama.go -Entwicklung war ich buchstäblich schockiert darüber, wie das originelle GGML.CPP -Projekt es sehr deutlich machte - es gibt keine Grenzen für talentierte Menschen, um Mind -Blowing -Merkmale zu bringen und in die KI -Zukunft zu ziehen.

Deshalb habe ich beschlossen, ein neues Projekt zu starten, bei dem der erstklassige C ++ / CUDA-Kern in den mächtigen Golang-Server eingebettet wird, der in großem Maßstab in realen Produktionsumgebungen für eine robuste und leistungsfähige Inferenz bereit ist.

Booster wurde (und immer noch) auf Mac mit Apple Silicon M1 -Prozessor entwickelt, daher ist es wirklich einfach: Peasy:

make macFolgen Sie Schritt 1 und Schritt 2, dann machen Sie einfach!

Ubuntu Schritt 1: Installieren Sie C ++ - und Golang -Compiler sowie einige Entwicklerbibliotheken

sudo apt update -y && sudo apt upgrade -y &&

apt install -y git git-lfs make build-essential &&

wget https://golang.org/dl/go1.21.5.linux-amd64.tar.gz &&

tar -xf go1.21.5.linux-amd64.tar.gz -C /usr/local &&

rm go1.21.5.linux-amd64.tar.gz &&

echo 'export PATH="${PATH}:/usr/local/go/bin"' >> ~/.bashrc && source ~/.bashrc

Ubuntu Schritt 2: Installieren Sie NVIDIA -Treiber und Cuda Toolkit 12.2 mit NVCC

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/cuda-ubuntu2204.pin &&

sudo mv cuda-ubuntu2204.pin /etc/apt/preferences.d/cuda-repository-pin-600 &&

sudo apt-key adv --fetch-keys https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/3bf863cc.pub &&

sudo add-apt-repository "deb http://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/ /" &&

sudo apt update -y &&

sudo apt install -y cuda-toolkit-12-2

Jetzt bist du bereit zu rocken!

make cudaSie besuchen die folgenden Schritte:

make clean && make macwget https://huggingface.co/NousResearch/Hermes-2-Pro-Llama-3-8B-GGUF/resolve/main/Hermes-2-Pro-Llama-3-8B-Q4_K_M.ggufid: mac

host: localhost

port: 8080

log: booster.log

deadline: 180

pods:

gpu:

model: hermes

prompt: chat

sampling: janus

threads: 1

gpus: [ 100 ]

batch: 512

models:

hermes:

name: Hermes2 Pro 8B

path: ~ /models/Hermes-2-Pro-Llama-3-8B-Q4_K_M.gguf

context: 8K

predict: 1K

prompts:

chat:

locale: en_US

prompt: " Today is {DATE}. You are virtual assistant. Please answer the question. "

system: " <|im_start|>systemn{PROMPT}<|im_end|> "

user: " n<|im_start|>usern{USER}<|im_end|> "

assistant: " n<|im_start|>assistantn{ASSISTANT}<|im_end|> "

samplings:

janus:

janus: 1

depth: 200

scale: 0.97

hi: 0.99

lo: 0.96Starten Sie Booster im interaktiven Modus, um nur mit dem Modell zu chatten:

./boosterStarten Sie Booster als Server, um alle API -Endpunkte zu verarbeiten und Debug -Informationen anzeigen:

./booster --server --debughttp://localhost:8080/jobs {

" id " : " 5fb8ebd0-e0c9-4759-8f7d-35590f6c9fc6 " ,

" prompt " : " Who are you? "

}http://localhost:8080/jobs/5fb8ebd0-e0c9-4759-8f7d-35590f6c9fc6 {

{

" id " : " 5fb8ebd0-e0c9-4759-8f7d-35590f6c9f77 " ,

" output " : " I'm a virtual assistant. " ,

" prompt " : " Who are you? " ,

" status " : " finished "

}

}booster.service -Datei zum Erstellen von Dämond -Dienst aus diesem API -Server.