Das Chatgpt-Schweizer Armeemesser für den modernen Entwickler! Wir bieten einen AI-angetriebenen CLI-Git-Wrapper, einen Boilerplate-Codegenerator, eine Code-Suchmaschine, einen Gesprächsverlauf und vieles mehr!

Voraussetzung:

chat with documents verwenden möchten. brew tap mindflowai/homebrew-mindflow && brew install mindflow

pip install mindflow

pip install -e path/to/mindflow

mf login ausführen: Konfigurieren Sie das Modell, das zum Generieren von Antworten verwendet wird, indem mf config ausgeführt wird und entweder GPT 3.5 Turbo (Standard) oder GPT 4 ausgewählt wird. Um GPT 4 zu verwenden, müssen Sie einen speziellen Zugriff auf die API haben. Wenn Sie Zugriff haben, können Sie mf config ausführen und GPT 4 auswählen. Wenn Sie keinen Zugriff haben, erhalten Sie eine Fehlermeldung.

Die Verwendung von Mindflows Chat -Funktion hat mehrere Ebenen.

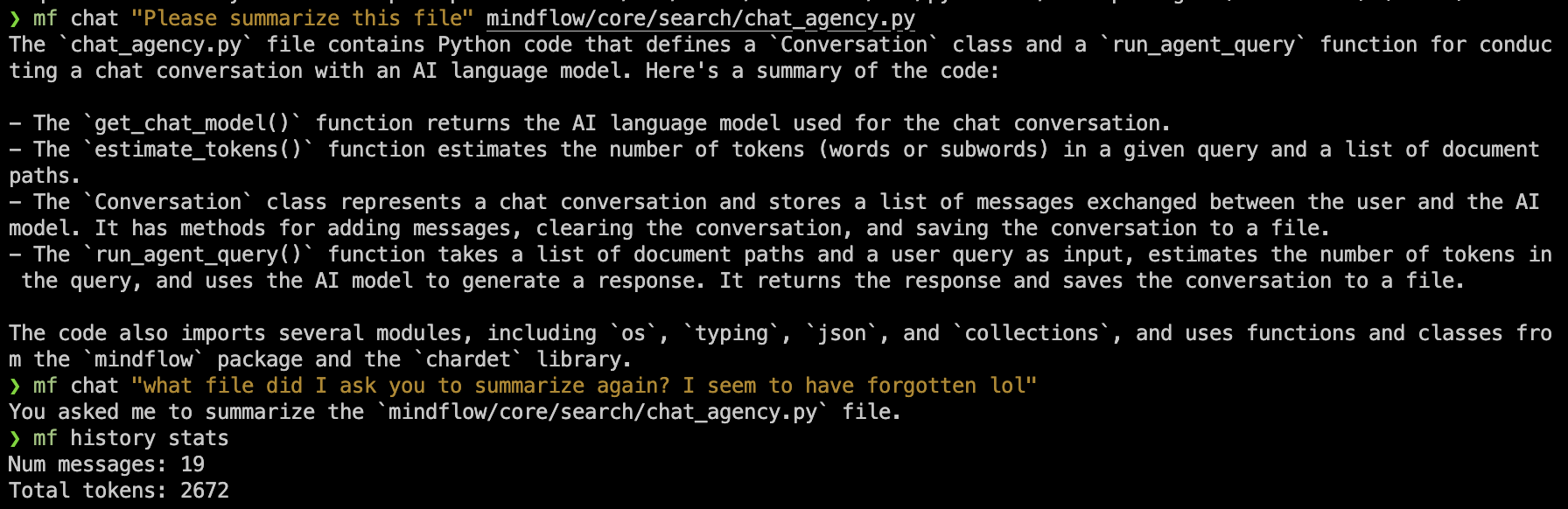

mf chat "explain what a programming language is"mf chat path/to/code.py "please summarize what this code does"mf chat Anruf übergeben. Für ausreichend kleine Dateien (siehe: Chatgpt -Token -Grenzen) funktioniert dies und behält auch den Chat -Historie bei.mf chat path/to/submodule1/ path/to/submodule2/ "what are these submodules responsible for?"mf index path/to/subdir/file1.txt path/to/file2.txtmf chat -s ./ "How do all of my classes relate to one another?"-s überspringt die automatische Indexierung und schenkt sich stattdessen auf den aktuell vorhandenen Index. Dieser Index wird im ersten Schritt mf index generiert, in dem nur diese Dateien/Subdirs enthalten sind. Sie können Mindflow verwenden, um mit mf gen einen Boilerplate -Code zu generieren! Es sollte nur Code und Kommentare generieren und die Datei im angegebenen Pfad speichern.

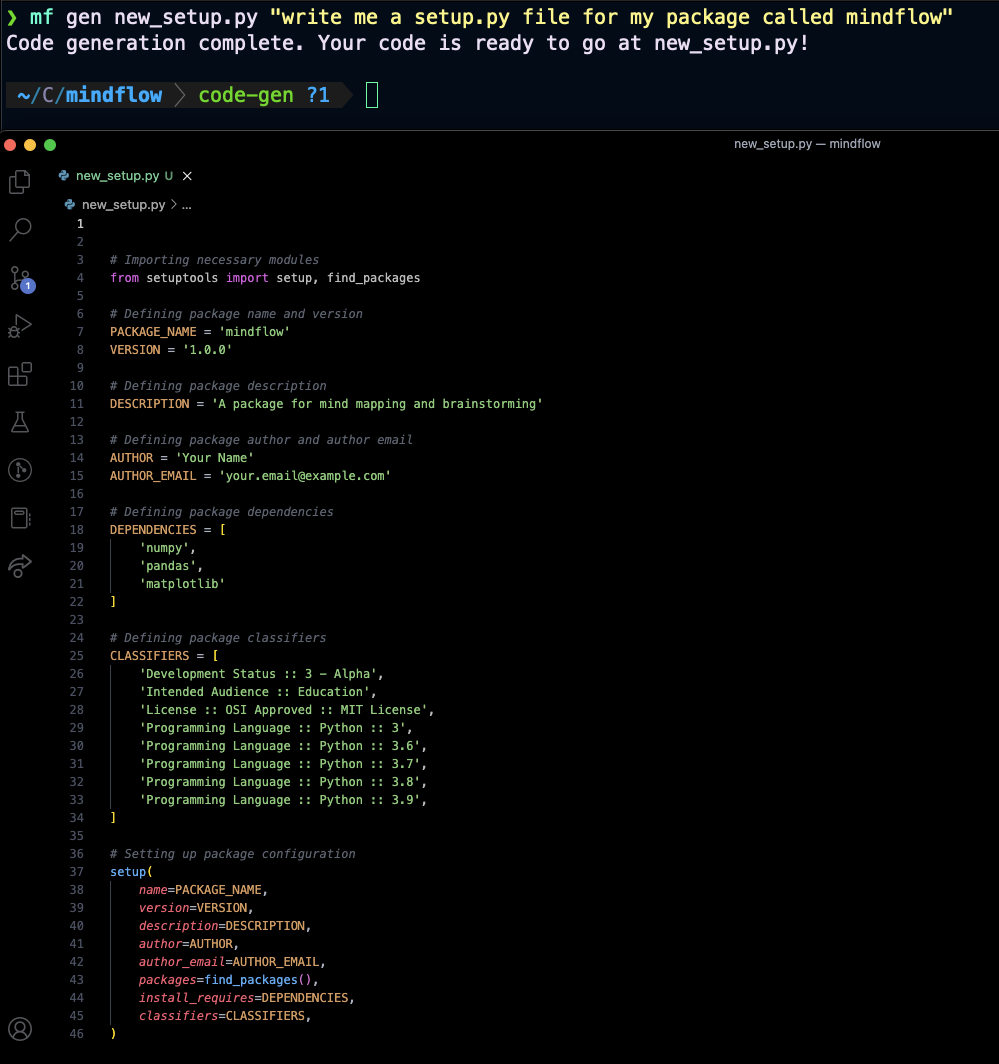

Hier sind ein paar Beispiele:

mf gen setup.py "write me a setup.py file for my python package 'foobar'"mf gen main.py "write me a python script with a main if block that prints the first 10 fibonacci numbers"Standardmäßig werden einfache Chat -Nachrichten (bei Bezug auf keine Dateien oder sehr kleinen Dateien) lokal gespeichert, damit Sie die Chat -Persistenz beibehalten können.

Um Statistiken über Ihren Chat -Verlauf zu sehen, können Sie mf history stats ausführen.

Wenn Sie Ihren Chat -Verlauf löschen möchten, können Sie mf history clear ausführen und es wird alle früheren Nachrichten vergessen, die Sie gesendet haben.

Wenn Sie versuchen, Ihren Chat -Nachrichten Verzeichnisse hinzuzufügen, wird die Chat -Persistenz deaktiviert und es wird kein vorheriger Kontext verwendet. Dies wird sich ändern, wenn Mindflow reift, und die OpenAI -API unterstützt nativ mehr Token -Levels/Konversationsgeschichten.

Hinweis: Git -Diff -Zusammenfassungen unterstützen die Chat -Persistenz noch nicht.

Nehmen Sie einige Änderungen an Ihrem Git -Repo vor, ohne sie zu inszenieren/zu begehen. Dann laufen Sie mf diff ! Sie sollten eine Antwort erhalten, die so aussieht:

`mindflow/commands/diff.py` changes:

- Added import statement for `List` and `Tuple` from the `typing` module.

- Added a function `parse_git_diff` that takes in the output of a `git diff` command and returns a list of tuples containing the file name and the diff content.

- Added a function `batch_git_diffs` that takes in the list of tuples returned by `parse_git_diff` and batches them into smaller chunks of diffs that are less than 3000 characters long.

- Modified the `diff` function to use the new `parse_git_diff` and `batch_git_diffs` functions to batch the diffs and send them to the GPT model for processing.

`mindflow/commands/inspect.py` changes:

- Removed the `print` statement used to output the result of a database query. The git diff shows changes in two files: `mindflow/commands/diff.py` and `mindflow/commands/inspect.py`.

`mindflow/commands/diff.py` changes:

- Added import statement for `List` and `Tuple` from the `typing` module.

- Added a function `parse_git_diff` that takes in the output of a `git diff` command and returns a list of tuples containing the file name and the diff content.

- Added a function `batch_git_diffs` that takes in the list of tuples returned by `parse_git_diff` and batches them into smaller chunks of diffs that are less than 3000 characters long.

- Modified the `diff` function to use the new `parse_git_diff` and `batch_git_diffs` functions to batch the diffs and send them to the GPT model for processing.

`mindflow/commands/inspect.py` changes:

- Removed the `print` statement used to output the result of a database query.

Nehmen Sie einige Änderungen an Ihrem Git -Repo vor und geben Sie sie auf. Dann führen Sie mf commit ! Sie sollten eine Antwort erhalten, die so aussieht:

[formatting 7770179] Add needs_push() function and check in run_pr() function.

1 file changed, 14 insertions(+)

Nehmen Sie einige Änderungen an Ihrem Zweig und Ihrer Bühne vor und verpflichten Sie sie. Dann führen Sie mf pr für GitHub oder mf mr für GitLab aus! Eine Pull -Anfrage/Merge -Anfrage sollte mit einem von GPT erzeugten Titel und Körper erstellt werden, und ein Link zum PR sollte in die Konsole gedruckt werden.

Mindflow verwendet hochmoderne Methoden für die Hochdurchsatz-Segmentierung, -verarbeitung, Speicherung und Abruf von Dokumenten unter Verwendung einer rekursiven hierarchischen Zusammenfassung und Einbettungstechnik, um die Einbettung von Vektoren für Dokumentenbrocken zu speichern, und dann schnelle und hochwertige Antworten auf Fragen und Aufgaben, die ähnliche Dokumentbahnen basieren, basierend auf den Hierarchisch-in-auf-qualy-query. Darüber hinaus bleibt der Chat -Verlauf bestehen, wenn er in den Kontext für Abfragen über indexierte Dokumente oder für reguläre Chat passen kann.

In Zukunft plant Mindflow, ein noch ein wesentlicherer Bestandteil des Toolkit des modernen Entwicklers zu werden. Wir planen, die Möglichkeit hinzuzufügen, traditionelle Dokumentation abzugeben und sich stattdessen direkt in Ihre privaten Dokumente und Kommunikationskanäle zu integrieren, um ein nahtloser und intuitiverer Erfahrungen zu ermöglichen. Mit Mindflow können Sie einen echten "Bewusstseinsstrom" mit Ihren Code, Dokumentation und Kommunikationskanälen haben, um es einfacher denn je zu machen, Ihre Projekte auf dem Laufenden zu halten und mit Ihrem Team zusammenzuarbeiten. Wir freuen uns, weiterhin die Grenzen dessen zu überschreiten, was mit Sprachmodellen möglich ist und die Funktionsweise von Entwicklern revolutioniert.