Dieses Repository enthält Demo -Programme für den Talking Head Anime aus einem einzigen Bild 2: Ausdrucksvoller. Ähnlich wie bei der vorherigen Version haben es zwei Programme:

manual_poser können Sie den Gesichtsausdruck und die Kopfdrehung eines Anime -Zeichens, das in einem einzelnen Bild über eine grafische Benutzeroberfläche angegeben ist, manipulieren. Der Poser ist in zwei Formularen erhältlich: einer Standard -GUI -Anwendung und einem Jupyter -Notizbuch.ifacialmocap_puppeteer können Sie Ihre Gesichtsbewegung, die von einer kommerziellen iOS -Anwendung namens iFacialMocap erfasst wird, auf ein Bild eines Anime -Charakters übertragen. Wenn Sie nicht über die erforderliche Hardware (unten besprochen werden) oder den Code nicht herunterladen und eine Umgebung einrichten möchten, um ihn auszuführen, klicken Sie auf, um den manuellen Poser auf Google Colab auszuführen.

Beide Programme erfordern eine aktuelle und leistungsstarke NVIDIA -GPU. Ich könnte sie persönlich mit der Nvidia Titan RTX mit guter Geschwindigkeit laufen lassen. Ich denke jedoch, dass die jüngsten High-End-GPUs wie die RTX 2080, der RTX 3080 oder besser genauso gut funktionieren würden.

Das ifacialmocap_puppeteer benötigt ein iOS -Gerät, das in der Lage ist, Mischformparameter aus einem Video -Feed zu berechnen. Dies bedeutet, dass das Gerät in der Lage sein muss, iOS 11.0 oder höher auszuführen und über eine truedpth-vorne-Kamera zu verfügen. (Weitere Informationen finden Sie in dieser Seite.) Mit anderen Worten, wenn Sie das iPhone X oder etwas Besseres haben, sollten Sie alle festgelegt sein. Persönlich habe ich ein iPhone 12 Mini verwendet.

Beide Programme wurden in Python 3 geschrieben. Um die GUIs auszuführen, sind die folgenden Softwarepakete erforderlich:

Insbesondere habe ich die Umgebung erstellt, um die Programme mit Anaconda mit den folgenden Befehlen auszuführen:

> conda create -n talking-head-anime-2-demo python=3.8

> conda activate talking-head-anime-2-demo

> conda install pytorch torchvision cudatoolkit=10.2 -c pytorch

> conda install scipy

> pip install wxPython

> conda install matplotlib

Hinweis: Sie können feststellen, dass die jeweiligen Versionen von Python (3.8) und CUDA Toolkit (10.2) möglicherweise nicht für Ihr spezielles Computer -Setup funktionieren. Ersetzen Sie diese Versionen durch diejenigen, die mit Ihrer Hardware arbeiten. Der Befehl würde werden:

> conda create -n talking-head-anime-2-demo python=[YOUR-PYTHON-VERSION]

> conda activate talking-head-anime-2-demo

> conda install pytorch torchvision cudatoolkit=[YOUR-CUDA-TOOLKIT-VERSION] -c pytorch

> conda install scipy

> pip install wxPython

> conda install matplotlib

Im Allgemeinen würde die neueste Version von Python und die neueste Version von Cuda Toolkit auf der Website von Pytorch funktionieren.

Um die Jupyter -Notebook -Version des manual_poser auszuführen, benötigen Sie auch:

Dies bedeutet, dass Sie zusätzlich zu den obigen Befehlen auch ausführen müssen:

> conda install -c conda-forge notebook

> conda install -c conda-forge ipywidgets

> jupyter nbextension enable --py widgetsnbextension

Zuletzt benötigt das ifacialmocap_puppeteer iFacialMocap, der im App Store für 980 Yen erhältlich ist. Sie müssen auch die gepaarte Desktop -Anwendung auf Ihrem PC oder Mac installieren. (Linux -Benutzer, es tut mir leid!) Ihr iOS und Ihr Computer müssen auch dasselbe Netzwerk verwenden. (Zum Beispiel können Sie sie mit demselben drahtlosen Router anschließen.)

Sie können auch Anaconda verwenden, um alle Python -Pakete in einem Befehl herunterzuladen und zu installieren. Öffnen Sie Ihre Shell, ändern Sie das Verzeichnis, wo Sie das Repository klonen, und führen Sie aus:

conda env create -f environment.yml

Dadurch wird eine Umgebung namens talking-head-anime-2-demo geschaffen, die alle erforderlichen Python-Pakete enthält.

Bevor Sie die Programme ausführen, müssen Sie die Modelldateien von diesem Dropbox -Link herunterladen und in den data des Repository -Verzeichnisses entpacken. Am Ende sollte der data wie:

+ data

+ illust

- waifu_00.png

- waifu_01.png

- waifu_02.png

- waifu_03.png

- waifu_04.png

- waifu_05.png

- waifu_06.png

- waifu_06_buggy.png

- combiner.pt

- eyebrow_decomposer.pt

- eyebrow_morphing_combiner.pt

- face_morpher.pt

- two_algo_face_rotator.pt

Die Modelldateien werden mit der internationalen Lizenz der Creative Commons Attribution 4.0 verteilt, was bedeutet, dass Sie sie für kommerzielle Zwecke verwenden können. Wenn Sie sie jedoch verteilen, müssen Sie unter anderem sagen, dass ich der Schöpfer bin.

manual_poserÖffnen Sie eine Hülle. Ändern Sie Ihr Arbeitsverzeichnis in das Root -Verzeichnis des Repositorys. Dann rennen Sie:

> python tha2/app/manual_poser.py

Beachten Sie, dass Sie vor dem Ausführen des obigen Befehls möglicherweise die Python -Umgebung aktivieren müssen, die die erforderlichen Pakete enthält. Wenn Sie eine Umgebung mit Anaconda erstellt haben, wie oben erläutert, müssen Sie laufen

> conda activate talking-head-anime-2-demo

Wenn Sie die Umgebung noch nicht aktiviert haben.

manual_poser Jupyter NotebookÖffnen Sie eine Hülle. Aktivieren Sie die Umgebung. Ändern Sie Ihr Arbeitsverzeichnis in das Root -Verzeichnis des Repositorys. Dann rennen Sie:

> jupyter notebook

Ein Browserfenster sollte sich öffnen. Öffnen Sie darin tha2.ipynb . Sobald Sie dies getan haben, sollten Sie sehen, dass es nur eine Zelle hat. Führen Sie es aus. Scrollen Sie dann bis zum Ende des Dokuments nach unten und Sie werden die GUI dort sehen.

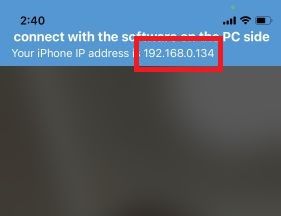

ifacialmocap_puppeteerFühren Sie zuerst IfacialMocap auf Ihrem iOS -Gerät aus. Es sollte Ihnen die IP -Adresse des Geräts zeigen. Notiere es. Halten Sie die App offen.

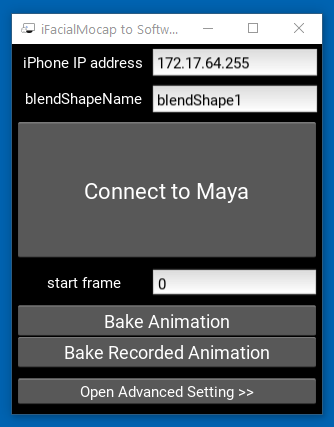

Führen Sie dann die Begleitdesktop -Anwendung aus.

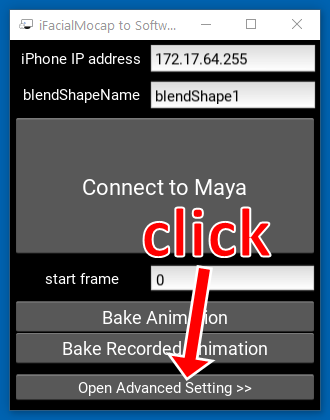

Klicken Sie auf "Erweiterte Einstellung >>". Die Anwendung sollte erweitern.

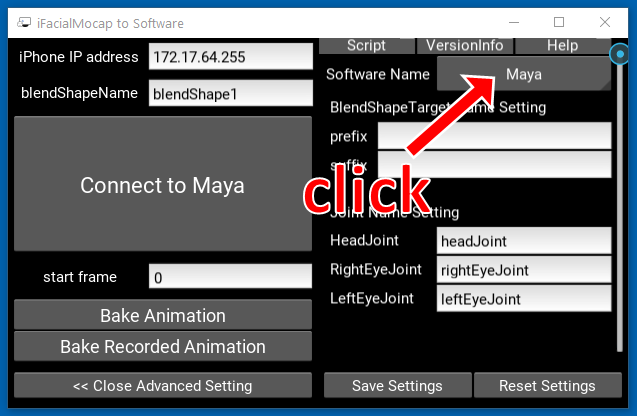

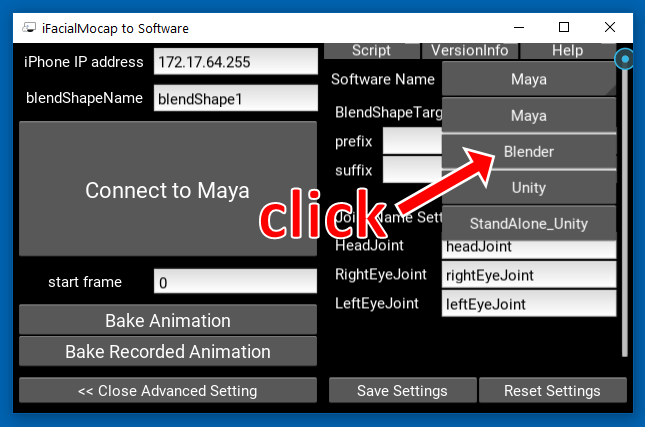

Klicken Sie auf die Schaltfläche mit der Aufschrift "Maya" auf der rechten Seite.

Klicken Sie dann auf "Mixer".

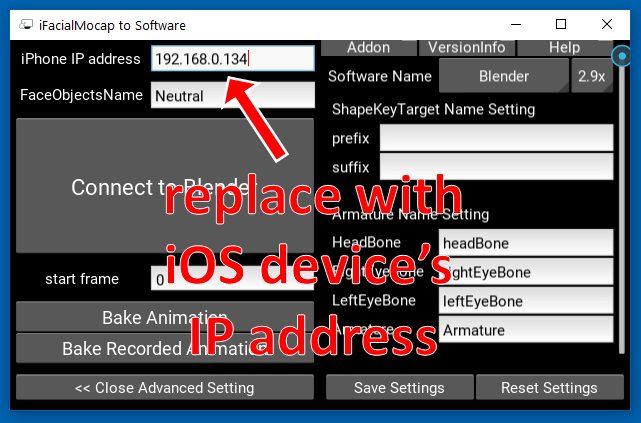

Ersetzen Sie als Nächstes die IP -Adresse auf der linken Seite durch die IP -Adresse Ihres iOS -Geräts.

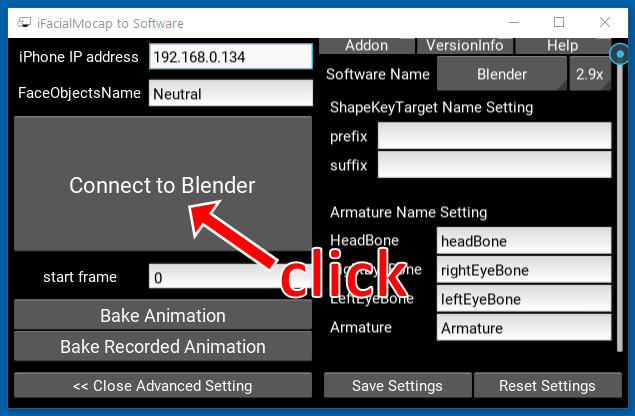

Klicken Sie auf "Verbindung zum Blender herstellen."

Öffnen Sie eine Hülle. Aktivieren Sie die Umgebung. Ändern Sie Ihr Arbeitsverzeichnis in das Root -Verzeichnis des Repositorys. Dann rennen Sie:

> python tha2/app/ifacialmocap_puppeteer.py

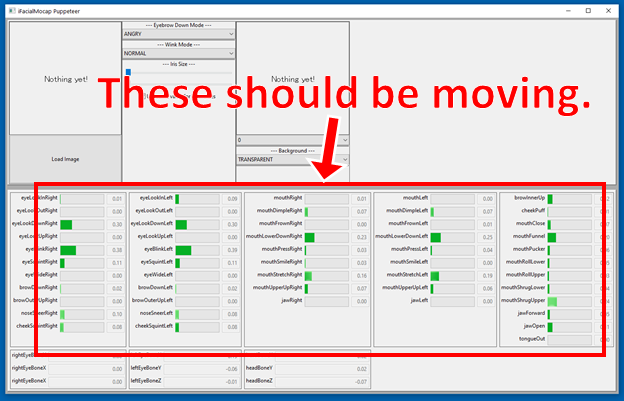

Wenn die Programme ordnungsgemäß verbunden sind, sollten Sie feststellen, dass sich die vielen Fortschrittsbalken am unteren Rand des Fensters ifacialmocap_puppeteer bewegen sollten, wenn Sie Ihr Gesicht vor die vordere Kamera des iOS-Geräts bewegen.

Wenn alles in Ordnung ist, laden Sie ein Zeichenbild und es sollte Ihrer Gesichtsbewegung folgen.

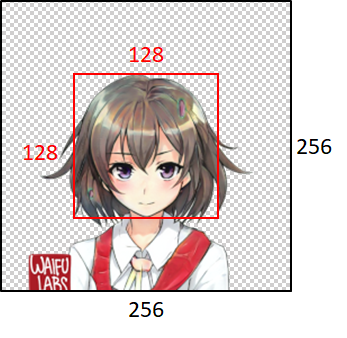

Damit das Modell gut funktioniert, muss das Eingabebild den folgenden Einschränkungen befolgen:

Beachten Sie jedoch, dass die Programme unabhängig von der Größe des Eingabebildes es immer auf 256x256 ändern und immer ein 256x256 -Bild ausgeben. Dies ist eine intrinsische Einschränkung des Systems.

Wenn Ihre akademische Arbeit aus dem Code in diesem Repository profitiert, zitieren Sie bitte die Webseite des Projekts wie folgt:

Pramook Khungurn. Talking Head Anime von einem einzelnen Bild 2: Ausdrucklicher. http://pkhungurn.github.io/talking-head-anime-2/, 2021. Zugriff: yyyy-mm-dd.

Sie können auch den folgenden Bibtex -Eintrag verwenden:

@misc{Khungurn:2021,

author = {Pramook Khungurn},

title = {Talking Head Anime from a Single Image 2: More Expressive},

howpublished = {url{http://pkhungurn.github.io/talking-head-anime-2/}},

year = 2021,

note = {Accessed: YYYY-MM-DD},

}

Während der Autor ein Mitarbeiter von Google Japan ist, ist diese Software nicht das Produkt von Google und wird von Google nicht unterstützt.

Das Urheberrecht dieser Software gehört mir, da ich sie mit dem IARC -Prozess angefordert habe. Google könnte jedoch die Rechte an dem geistigen Eigentum dieser Erfindung beanspruchen.

Der Code wird unter der MIT -Lizenz veröffentlicht. Das Modell wird unter der internationalen Lizenz der Creative Commons Attribution 4.0 veröffentlicht.