يحتوي هذا المستودع على رمز لتشغيل نموذج لغة التوصيل والتشغيل (PPLM) ، كما هو موضح في منشور المدونة وورقة Arxiv . يتوفر دفتر ملاحظات تجريبي وكولاب أيضًا.

ملاحظة: إذا كنت تخطط لاستخدام PPLM كخط أساسي ، وترغب في استخدام المعلمات المدرجة في ملحق الورقة ، فيرجى استخدام LM والميكرات من هذا المجلد . بدلاً من ذلك ، قم بضبط الفائزين بمفردك إذا كنت تستخدم الكود/النماذج في الدليل الرئيسي و/أو المحولات/المحولات للمقارنة العادلة (المعلمات المثلى لهذه النماذج/التمييز هي تقريبًا بعامل 5 من تلك المستخدمة في الورقة).

تم دمج PPLM أيضا في مستودع ؟/Transformers .

المؤلفون: Sumanth Dathathri ، Andrea Madotto ، Janice Lan ، Jane Hung ، Eric Frank ، Piero Molino ، Jason Yosinski ، and Rosanne Liu

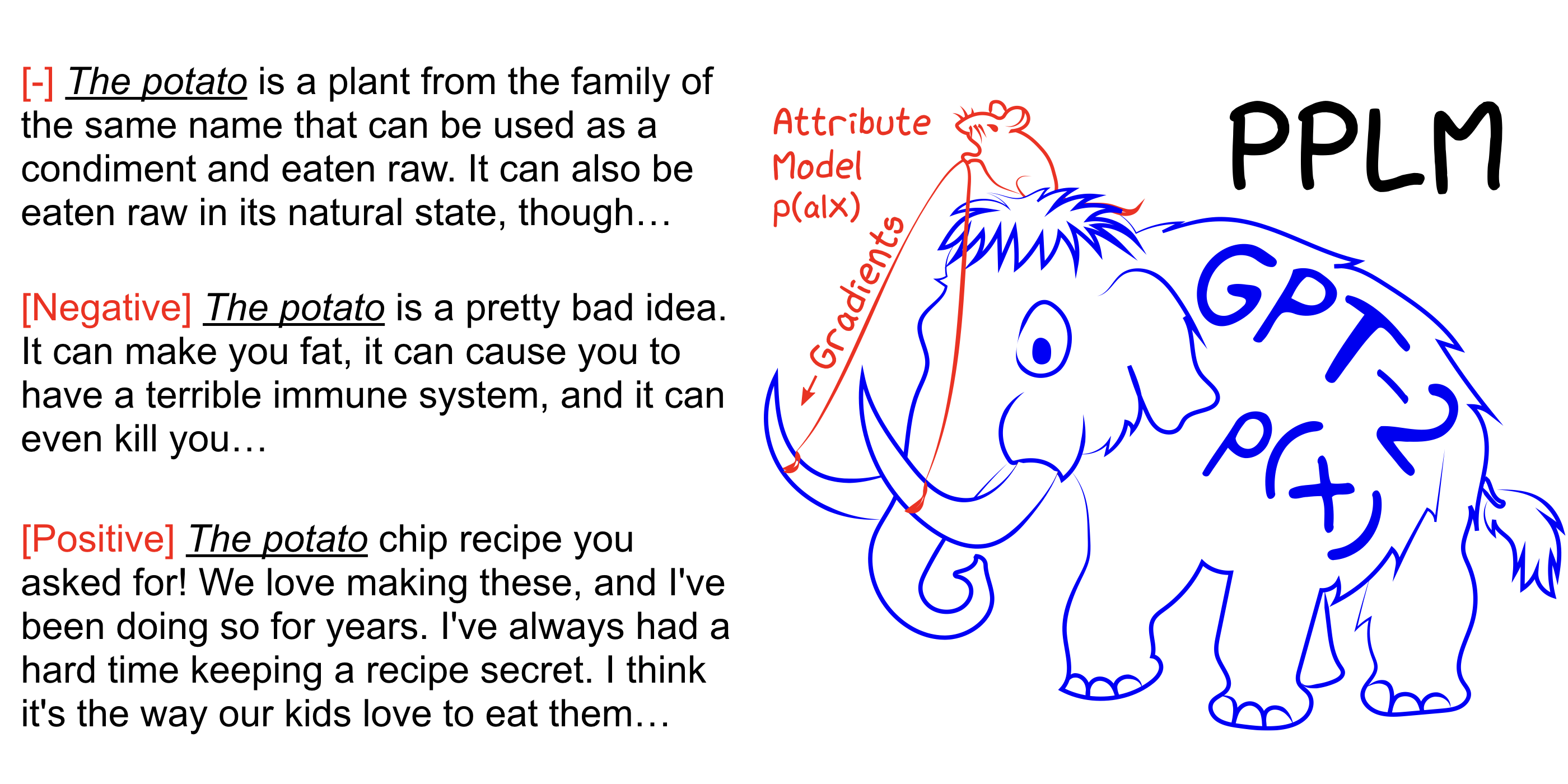

يتيح PPLM للمستخدم توصيل نماذج سمة صغيرة أو أكثر بمرونة تمثل هدف التوجيه المطلوب في نموذج لغة كبير غير مشروط (LM). تحتوي هذه الطريقة على خاصية رئيسية أنه يستخدم LM كما هو -لا يلزم التدريب أو الضبط-مما يتيح للباحثين الاستفادة من أفضل LMS في فئتها حتى لو لم يكن لديهم الأجهزة الواسعة المطلوبة لتدريبهم.

راجع أيضًا ورقة Arxiv ، منشور المدونة ، وجربها بنفسك بدون إعداد باستخدام دفتر Colab Notebook.

pip install -r requirements.txt @inproceedings{

Dathathri2020Plug,

title={Plug and Play Language Models: A Simple Approach to Controlled Text Generation},

author={Sumanth Dathathri and Andrea Madotto and Janice Lan and Jane Hung and Eric Frank and Piero Molino and Jason Yosinski and Rosanne Liu},

booktitle={International Conference on Learning Representations},

year={2020},

url={https://openreview.net/forum?id=H1edEyBKDS}

}

python run_pplm.py -B military --cond_text " The potato " --length 50 --gamma 1.5 --num_iterations 3 --num_samples 10 --stepsize 0.03 --window_length 5 --kl_scale 0.01 --gm_scale 0.99 --colorama --sample زيادة --stepsize لتكثيف التحكم في الموضوع ، وتقليل قيمتها لتليين التحكم. --stepsize 0 يستعيد نموذج GPT-2 الأصلي.

إذا كانت اللغة التي يتم إنشاؤها متكررة (على سبيل المثال "تجربة علوم العلوم") ، فهناك العديد من الخيارات التي يجب مراعاتها:

أ) تقليل --stepsize

ب) زيادة- --kl_scale (معامل KL-LOSS) أو النقص- --gm_scale (مصطلح تحديد GM)

C) إضافة --grad-length xx حيث XX هو (عدد صحيح <= الطول ، على سبيل المثال --grad-length 30 ).

python run_pplm.py -D sentiment --class_label 2 --cond_text " My dog died " --length 50 --gamma 1.0 --num_iterations 10 --num_samples 10 --stepsize 0.04 --kl_scale 0.01 --gm_scale 0.95 --sample زيادة --stepsize لتكثيف التحكم في الموضوع ، وتقليل قيمتها لتليين التحكم. --stepsize 0 يستعيد نموذج GPT-2 الأصلي.

use --class_label 3 for spelied ، و --class_label 2 for idential

يختلف التمييز ونموذج GPT-2 في دليل الجذر عن تلك المستخدمة للتحليل في الورقة. يمكن العثور على الكود والنماذج المقابلة للورقة هنا.