خادم Pico MLX هو أسهل طريقة للبدء في إطار عمل MLX AI الخاص بـ Apple

يوفر Pico MLX Server واجهة المستخدم الرسومية لخادم MLX. يوفر MLX Server واجهة برمجة تطبيقات لنماذج MLX المحلية تتوافق مع API Openai. يتيح لك ذلك استخدام معظم عملاء Openai دردشة مع خادم Pico MLX.

انظر مجتمع MLX على Luggingface

لتثبيت Pico MLX Server ، قم بإنشاء المصدر باستخدام Xcode ، أو تنزيل القابلة للتنفيذ مباشرة من Github.

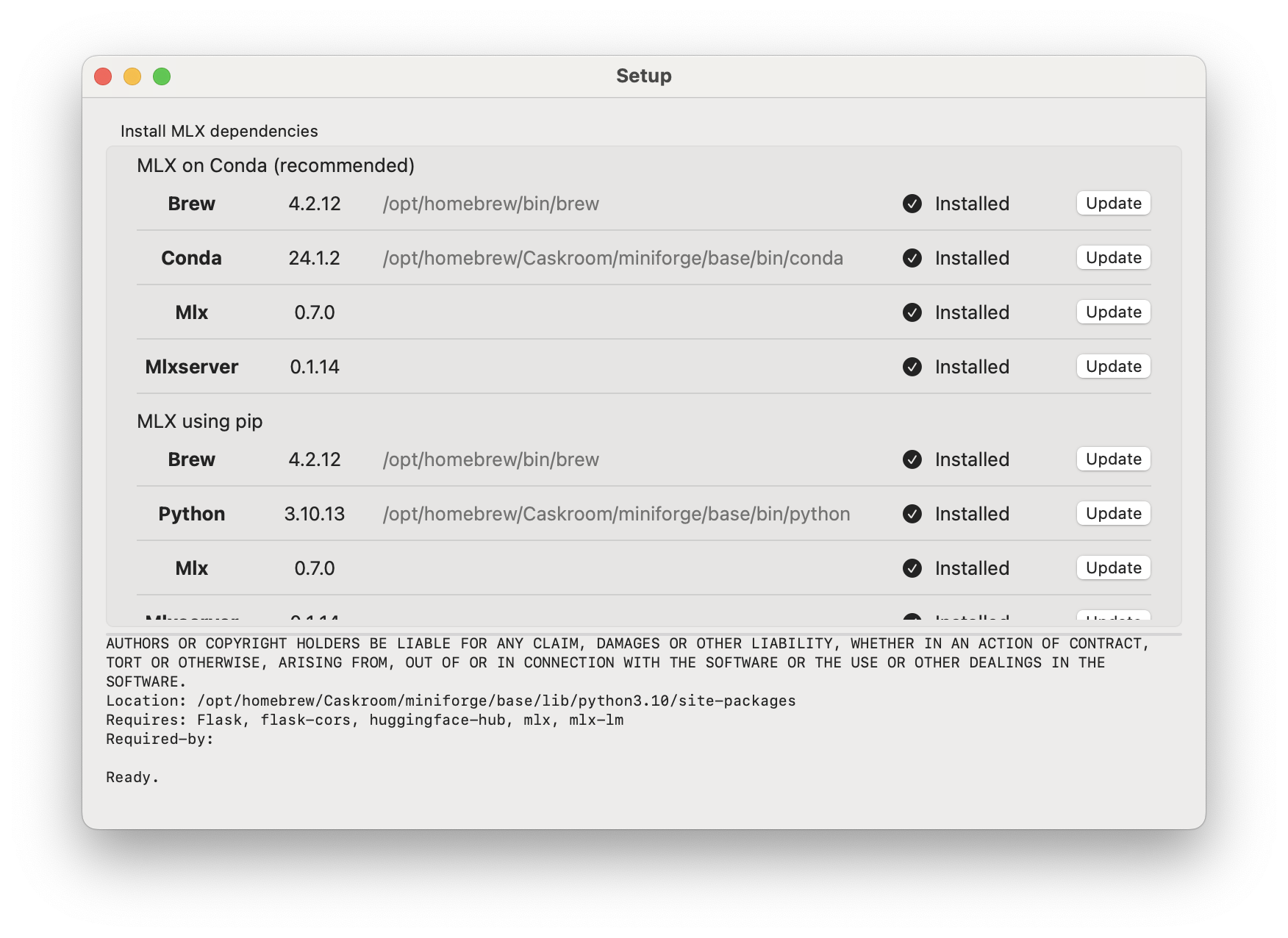

لإعداد خادم Pico MLX ، افتح التطبيق و

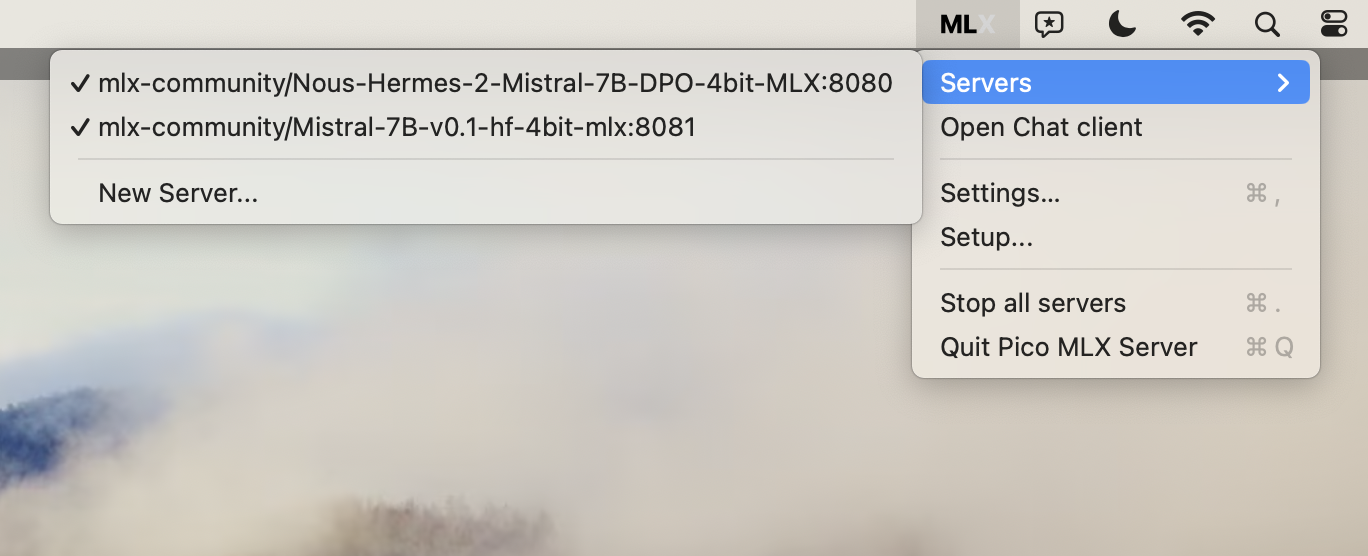

MLX -> Setup... )Settings

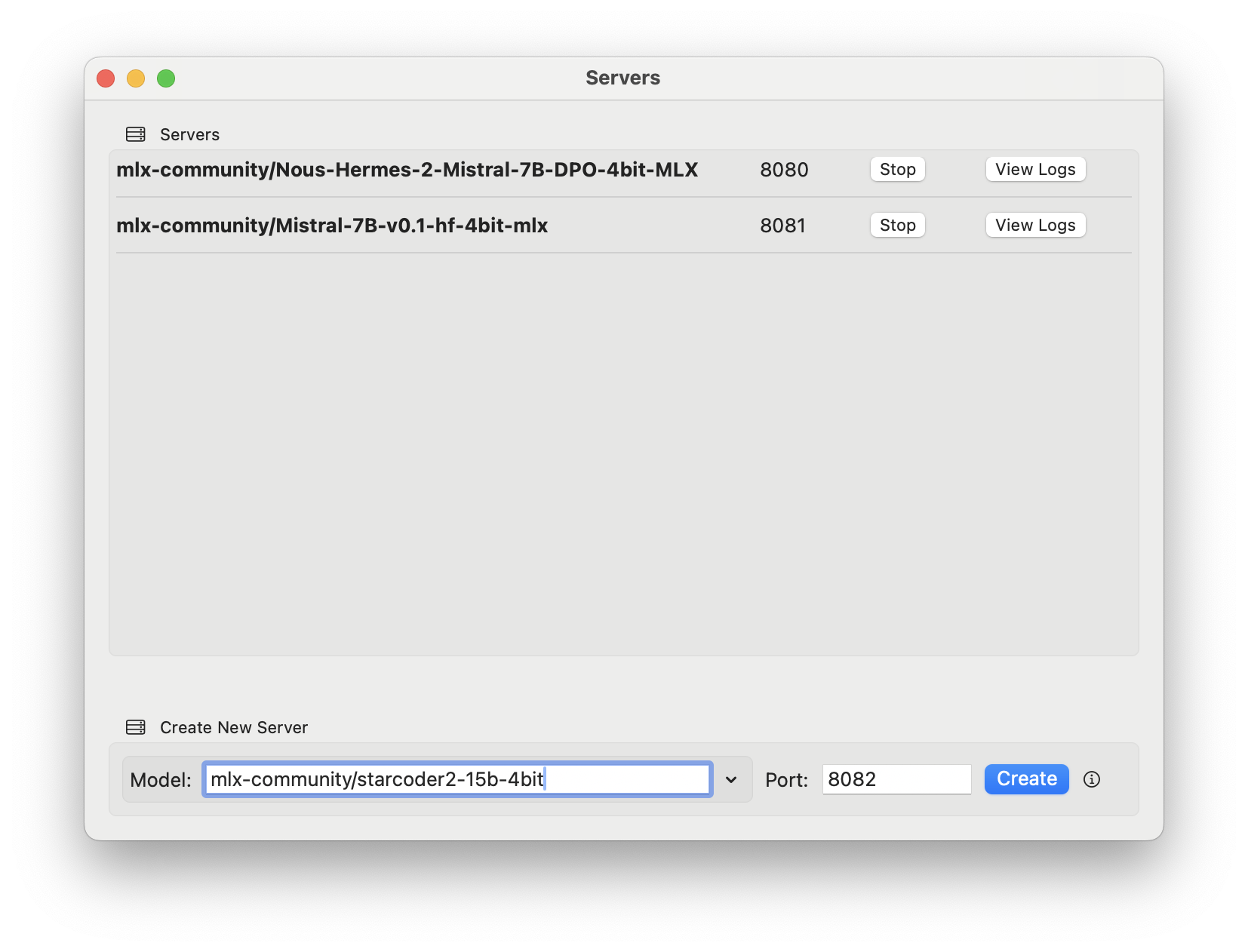

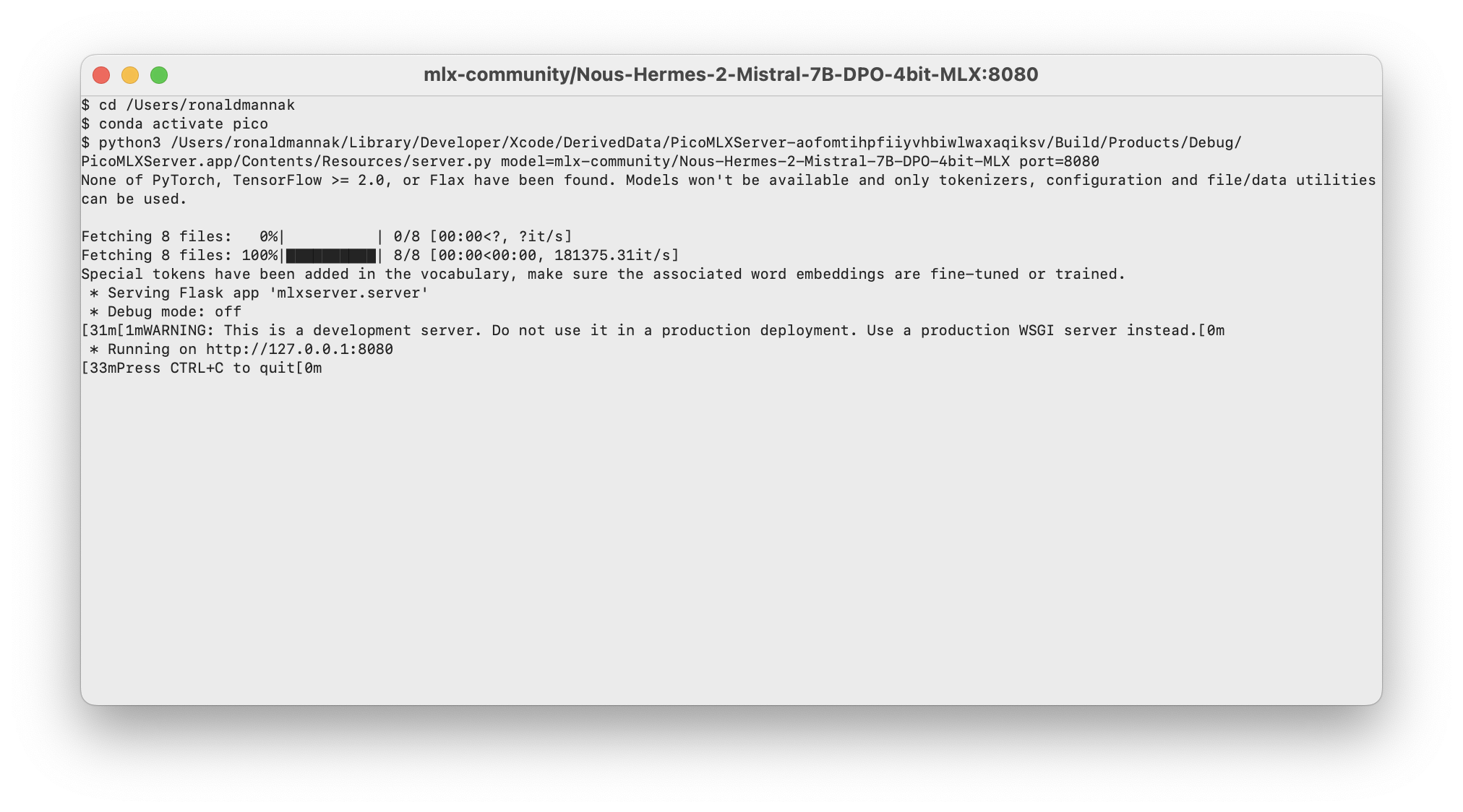

MLX -> Servers -> New Server...Create لإنشاء الخادم الافتراضي mlx-community/Nous-Hermes-2-Mistral-7B-DPO-4bit-MLX على المنفذ 8080v أو اكتب نموذجًا يدويًا من مجتمع MLX على Luggingface (تأكد من استخدام mlx-community/ Prefix)View Logs لفتح نافذة مع سجلات الخادم في الوقت الفعلي

قم بتوزيع أي مساعد AI AI Openai على http://127.0.0.1:8080 (أو أي منفذ آخر استخدمته في خادم Pico MLX). (تعليمات لمساعد Pico AI قريبًا)

حليقة:

curl -X GET 'http://127.0.0.1:8080/generate?prompt=write%20me%20a%20poem%20about%the%20ocean&stream=true'

POST /v1/completions . راجع لمزيد من المعلومات https://platform.openai.com/docs/api- المرجع/completions/create. lsof -i:8080 في المحطة للعثور على PID لخادم التشغيل)New Server وقائمة Servers حيث لا يتم تحديث حالة الخوادم يعد Pico MLX Server جزءًا من حزمة من أدوات SWIFT مفتوحة المصدر لمهندسي الذكاء الاصطناعي. هل تبحث عن وكيل Swift Openai Swift من جانب الخادم لحماية مفاتيح Openai؟ تحقق من Swift Openai Proxy.

تم إنشاء خادم Pico MLX ، وكيل سويفت Openai ، ومساعد Pico AI بواسطة Ronald Mannak بمساعدة من Ray Fernando

تم إنشاء خادم MLX بواسطة Mustafa Aljadery & Siddharth Sharma

الكود المستخدم من MLX Swift Chat و Swift Chat