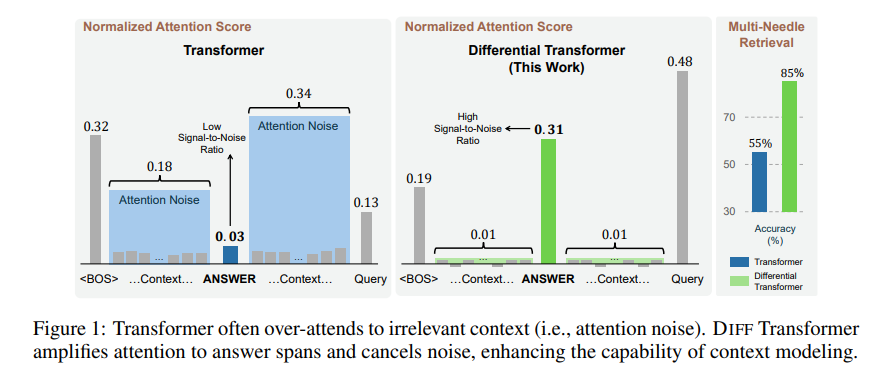

Университет Цинхуа и Microsoft объединились для создания дифференциального трансформатора, который позволяет искусственному интеллекту лучше концентрироваться и повышает его точность на 30 %!

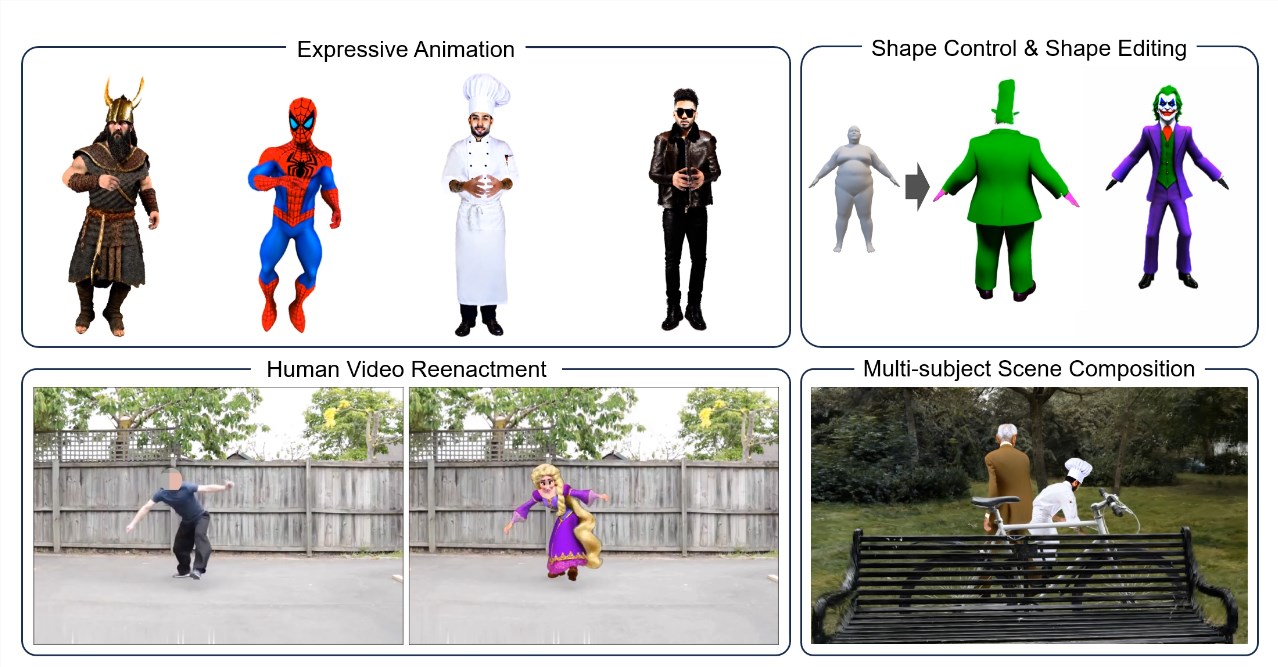

Интерпретация редактора Downcodes: механизму внимания модели Transformer часто мешает ненужная информация, что снижает эффективность. В последней статье предлагается дифференциальный трансформатор, который использует механизм дифференцированного внимания,

2025-03-03