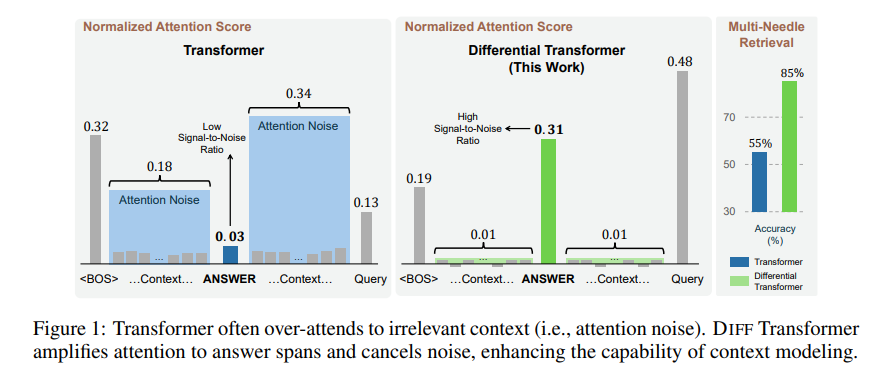

清華大学とマイクロソフトは協力して、AI の集中力を高め、精度を 30% 向上させる差動トランスを開発しました。

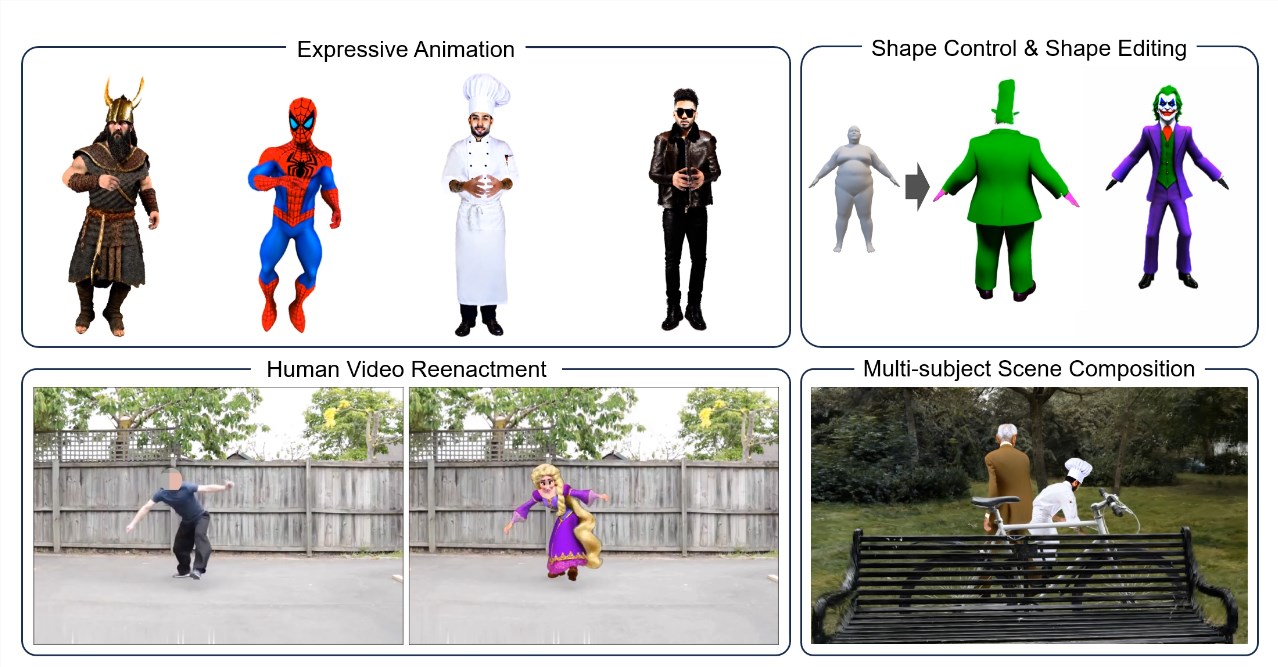

編集者の解釈をダウンコードする: Transformer モデルの注意メカニズムは、無関係な情報によって干渉されることが多く、効率が低下します。最新の論文では、「ノイズキャンセリングヘッドフォン」のような差動アテンションメカニズムを使用してアテンションノイズを除去する差動トランスを提案しています。実験の結果、このモデルは言語モデリング、長いテキスト処理などにおいて従来の Transformer よりも大幅に優れていることが示されています。同じ効果を達成するために必要なモデル サイズまたはトレーニング デー

2025-03-03